「人工知能 (AI) は言葉の意味を理解できるか?」という問いについて、

肯定論、否定論の両論あるようだ。

計算しかしていないコンピュータに、言葉の意味が理解できるはずが

ない、というような論が、かつて、まことしやかに述べられていた。

「コンピュータ」は、日本語では「計算機」といい、その名の示す通り、

プロセッサレベルの低い階層においては、計算しかしておらず、それ以外に

何かができるわけではない。そこは間違っていない。また、計算以外の

何かができるように、新たなアーキテクチャが生まれようとしている、と

いうこともなく、そこは昔も今も変わっていない。

しかし、一方、「言葉を理解するとは、単なる計算以上の能力を必要とする、

特別な何かである」かどうかは、それほど自明ではなく、議論の余地が

あると思う。

人間の脳だって、脳細胞や脳細胞間のシナプス結合等のミクロなレベルまで

視点を下げれば、もしかすると、本質的には計算しかしていないのかも

しれない。だとしても、そこから、マクロレベルへと階層を上がって

いくにつれて、知能や意識が創発してくるのかもしれない。意識も知能も

欲望も感情も想像力も直観力も言語能力も論理推論能力も、結局は

計算に還元されるのではないか、という考え方がある。これを

「計算主義」という。

もし、計算主義が正しいのだとしたら、人間の脳においても、実は

計算しかしていないのに、言葉を理解できているのはどういう

メカニズムによるものなのだろう、不思議だなぁ、と、AI の場合と同じ

問いに直面することになりうる。

自然言語処理能力を含む知能は計算から生まれるか、というのは割と

根源的な問いだと思う。

そこをただ思弁的に言葉だけを用いて議論していても、果てしなく続き、

言葉のゴミの山が積み上げられ、結局は、何ひとつ解明できずに終わる

だろう。ヴィトゲンシュタインの哲学を延々々々と続けていたとしても、

そこから自然言語処理 AI は生まれない。

今は、現に動作するチャットボット AI が世に出てきている。

さきほどの問いについて考える上でも、現物を触りながらのほうが、

議論の見通しがより明るくなるかと思う。

というわけで、ChatGPT と会話してみることで、考えてみた。

考察というより、ただの感想に近いけど。

「言葉の意味を理解する」とはどういうことか、それ自体、単純なこと

ではなく、理解レベルには、さまざまな階層があると思う。

車の自動運転だって、そのレベルが 5 段階に分類されており、

言葉の意味理解についても、そういうのがあるとよかろうと思う。

今現在、どのレベルまで到達しているのか。今、まだ解決されていない

課題は何か。将来、いつごろ、どの程度のものに発展するかの見通しは

どうか。こういう問いが、割と現実味のある、切実な問いになってきて

いるのではないかと思う。

このレポートを参照して解説する YouTube 動画:

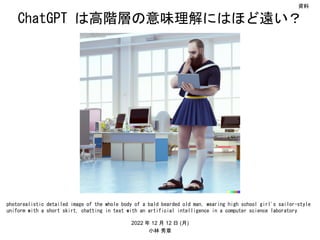

■ セーラー服で機関銃トーク: ChatGPT を使ってみた (第 3 弾)

https://www.youtube.com/watch?v=Cb3qJX8Sp-U

2022/12/15

収録日: 2022年12月12日(月)

YouTube 動画 35分14秒

YouTube チャンネル シンギュラリティサロン・オンライン

セーラー服で機関銃トーク: ChatGPT を使ってみた (第 3 弾)

2022年12月15日(木) の時点で視聴回数は 352 回。

Lire moins