ejemplo red neuronal Art1

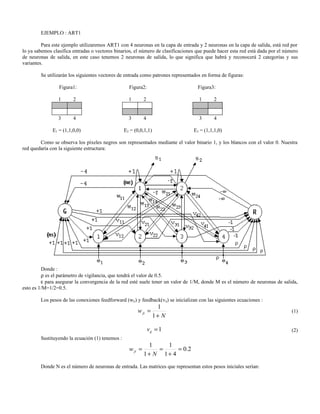

- 1. EJEMPLO : ART1 Para este ejemplo utilizaremos ART1 con 4 neuronas en la capa de entrada y 2 neuronas en la capa de salida, está red por lo ya sabemos clasifica entradas o vectores binarios, el número de clasificaciones que puede hacer esta red está dada por el número de neuronas de salida, en este caso tenemos 2 neuronas de salida, lo que significa que habrá y reconocerá 2 categorías y sus variantes. Se utilizarán los siguientes vectores de entrada como patrones representados en forma de figuras: Figura1: Figura2: Figura3: 1 2 1 2 1 2 3 4 3 4 3 4 E1 = (1,1,0,0) E2 = (0,0,1,1) E3 = (1,1,1,0) Como se observa los píxeles negros son representados mediante el valor binario 1, y los blancos con el valor 0. Nuestra red quedaría con la siguiente estructura: Donde : ρ es el parámetro de vigilancia, que tendrá el valor de 0.5. ε para asegurar la convergencia de la red esté suele tener un valor de 1/M, donde M es el número de neuronas de salida, esto es 1/M=1/2=0.5. Los pesos de las conexiones feedforward (wji) y feedback(vij) se inicializan con las siguientes ecuaciones : 1 w ji = (1) 1+ N vij = 1 (2) Sustituyendo la ecuación (1) tenemos : 1 1 w ji = = = 0 .2 1+ N 1+ 4 Donde N es el número de neuronas de entrada. Las matrices que representan estos pesos iniciales serían:

- 2. w11 w21 0.2 0.2 v v 21 v31 v 41 1 1 1 1 w w22 0.2 0.2 V = 11 = w = 12 = v 12 v 22 v32 v 42 1 1 1 1 w w23 0.2 0.2 13 w 14 w24 0.2 0.2 Ya inicializada la red, el vector de entrada es aplicado:: N ∑w i =1 e (k ) ji i (3) Utilizando la ecuación anterior, obtenemos los siguientes valores: 4 ∑w i =1 (1) e 1i i = (0.2)(1) + (0.2)(1) + (0.2)(0) + (0.2)(0) = 0.4 4 ∑w i =1 (1) 2i ie = (0.2)(1) + (0.2)(1) + (0.2)(0) + (0.2)(0) = 0.4 Como está es la primera información de entrada y los pesos wji son todos iguales, no hay ninguna neurona vencedora en la competición, por lo cual se almacena en la primera neurona de la capa de salida, con la siguiente ecuación: vij* (t + 1) = vij* (t )ei( k ) (4) Sustituyendo la ecuación (4): v11 = v11e1(1) = (1)(1) = 1 v 21 = v 21e21) = (1)(1) = 1 ( v31 = v31e31) = (1)(0) = 0 ( v 41 = v 41e41) = (1)(0) = 0 ( Así, los nuevos valores de V son: 1 1 0 0 V = 1 1 1 1 Así, para obtener los pesos de W se obtienen con la siguiente ecuación: (k ) vij* (t )ei w j*i (t + 1) = N (5) γ + ∑ vij* (t )ei( k ) i =1 Sustituyendo la ecuación (5): (1) v11e1 (1)(1) 1 w11 = = = = 0.4 N 0.5 + (1)(1) + (1)(1) + (1)(0) + (1)(0) 2.5 γ + ∑ vi1 (t )e1(1) i =1 (1) v 21e2 (1)(1) 1 w12 = = = = 0.4 N 0.5 + (1)(1) + (1)(1) + (1)(0) + (1)(0) 2.5 γ + ∑ vi1 (t )e1(1) i =1 (1) v31e3 (1)(0) 0 w13 = = = =0 N 0.5 + (1)(1) + (1)(1) + (1)(0) + (1)(0) 2.5 γ + ∑ vi1 (t )e1(1) i =1

- 3. (1) v 41e4 (1)(0) 0 w14 = = = =0 N 0.5 + (1)(1) + (1)(1) + (1)(0) + (1)(0) 2.5 γ + ∑ vi1 (t )e1(1) i =1 Obteniéndose los nuevos valores de W: 0 .4 0 .2 0 .4 0 .2 W = 0 0 .2 0 0 .2 Si a continuación se introduce el siguiente vector de entrada E 2 se producirá la competición en las neuronas de salida ,sustituyendo la ecuación (3) con los siguientes resultados: 4 ∑w i =1 ( 2) e 1i i = (0.4)(0) + (0.4)(0) + (0)(1) + (0)(1) = 0 4 ∑w i =1 ( 2) 2i i e = (0.2)(1) + (0.2)(1) + (0.2)(0) + (0.2)(0) = 0.4 Por lo tanto resulta vencedora la segunda neurona de la capa de salida por lo que al sustituir la ecuación (3) y (4) el resultado es el siguiente: 0.4 0 1 1 0 0 0.4 0 V = 0 0 1 1 W = 0 0.4 0 0.4 Por último, se presenta a la entrada el vector E3=(1,1,1,0) produciéndose la competición con la ecuación (3) con los siguientes resultados 4 4 ∑ w1i ei(3) = 0.8 i =1 ∑w i =1 e( 3) 2i i = 0.4 Como se observa la neurona vencedora es la primera de la capa de salida, por lo utilizaremos la siguiente ecuación de relación de semejanza: E 3V1 Re lación de semejanza = (6) E3 Sustituyendo la ecuación anterior tenemos: E 3V1 e1( 3) v11 + e23) v 21 + e33) v31 + e43) v 41 (1)(1) + (1)(1) + (1)( 0 ) + ( 0 )( 0 ) ( ( ( = = = 0.6 E3 e1( 3) + e23) + e33) + e43) ( ( ( 1+1+1+ 0 En este punto se deberá determinar si es suficiente la semejanza como para considerar que E 3=(1,1,1,0) es de la misma clase que E1=(1,1,1,0), para lo cual habrá que tener en consideración el parámetro de vigilancia. El cual es de 0.5, entonces 0.6>0.5, por lo que se consideraría de la misma clase y se procedería a modificar los pesos de V y W de la primera neurona, utilizando la ecuación (4) y la ecuación (5) para el ajuste de los pesos. Por lo que los nuevos valores serán:

- 4. 0 .4 0 1 1 0 0 0 .4 0 V = 0 0 1 1 W = 0 0 .4 0 0 .4 En todo caso si quisiéramos que pudiera clasificar E3=(1,1,1,0) se tendría que aumentar una nueva neurona de salida. Si esto se hiciera así, se ajustarían los pesos de esta tercera neurona de salida para que registrasen el prototipo de la nueva clase, con los pasos anteriores. Obteniéndose los siguientes vectores: 0.4 0 0.28 1 1 0 0 0.4 0 0.28 V = 0 0 1 1 W = 1 1 1 0 0 0.4 0.28 0 0.4 0