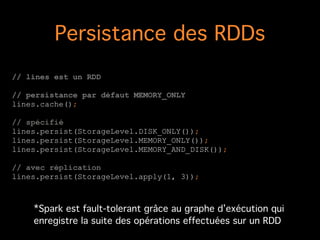

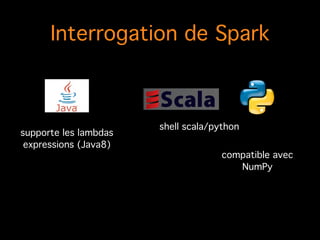

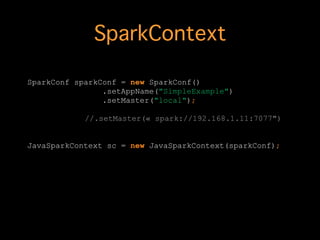

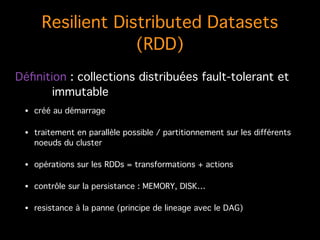

Le document présente une introduction à Apache Spark, mettant en avant ses capacités de traitement des données volumineuses avec des fonctionnalités telles que les Resilient Distributed Datasets (RDD). Il explique également la flexibilité d'implémentation, la compatibilité avec Hadoop, et les opérations sur les RDD, y compris la persistance et le traitement parallèle. Enfin, le document souligne la tolérance aux pannes grâce au principe de lineage dans le traitement des données.

![Créer un RDD

// sc est le SparkContext

!

// à partir d’un fichier texte

JavaRDD<String[]> lines = sc.textFile("ensemble-des-equipements-

sportifs-de-lile-de-france.csv");

!

// à partir d’un fichier venant d’Hadoop

sc.hadoopFile(path, inputFormatClass, keyClass, valueClass);

!](https://image.slidesharecdn.com/introductionspark-150825063555-lva1-app6891/85/Introduction-spark-11-320.jpg)

![Opérations sur les RDDs

JavaRDD<String[]> lines = sc.textFile("ensemble-des-equipements-

sportifs-de-lile-de-france.csv")

.map(line -> line.split(";"))

// suppression de la 1ère ligne

.filter(line -> !line[1].equals("ins_com"));

!

lines.count();

!

// nombre par type d'équipement rangé par ordre alphabétique

lines.mapToPair(line -> new Tuple2<>(line[3], 1))

.reduceByKey((x, y) -> x + y)

.sortByKey()

.foreach(t -> System.out.println(t._1 + " -> " + t._2));

!](https://image.slidesharecdn.com/introductionspark-150825063555-lva1-app6891/85/Introduction-spark-12-320.jpg)