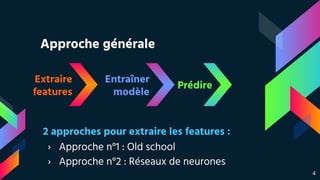

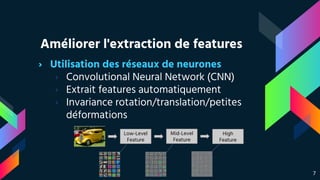

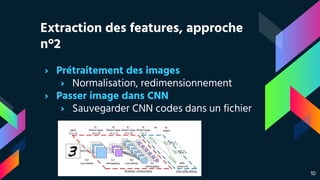

Ce document présente une approche de classification d'images en utilisant le deep learning, à travers une compétition où les participants ont prédit l'orientation des toits de bâtiments. Deux méthodes d'extraction des caractéristiques sont comparées : une approche traditionnelle avec extraction manuelle et une autre utilisant des réseaux de neurones convolutionnels, améliorant l'accuracy de 0,60 à 0,75. Les résultats montrent l'importance des modèles pré-entraînés et du fine-tuning pour optimiser les performances.