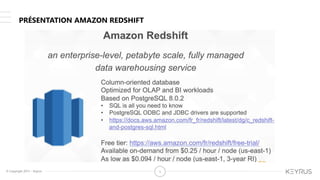

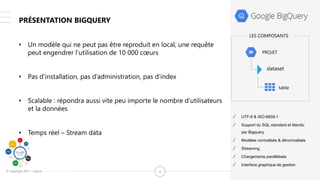

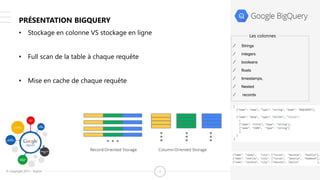

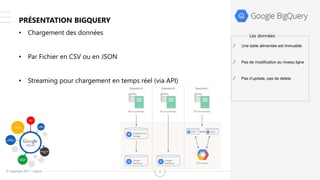

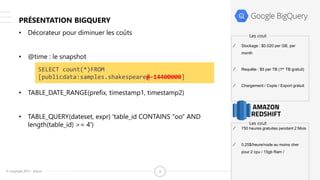

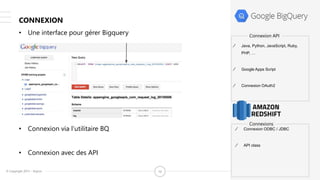

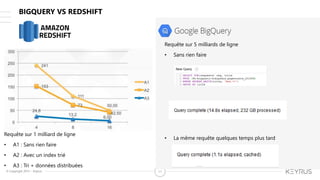

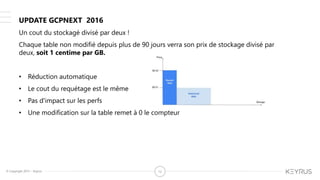

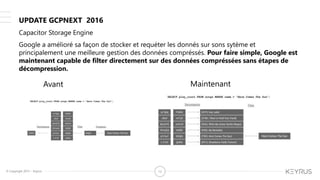

Le document présente les services cloud de BigQuery et Redshift, soulignant leurs capacités de traitement des données massives, leur évolutivité et les différentes méthodes de chargement et d'interrogation. Il aborde également les coûts liés au stockage et à l'exécution des requêtes, ainsi que des fonctionnalités récentes comme l'optimisation du stockage et le partitionnement automatique. Finalement, des comparaisons entre BigQuery et Redshift sont mentionnées, illustrant les performances et les économies potentielles sur le stockage des données.