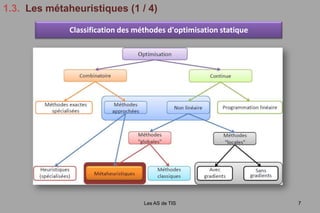

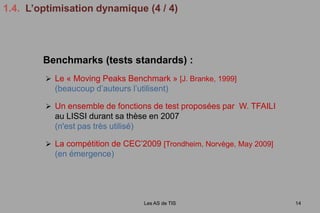

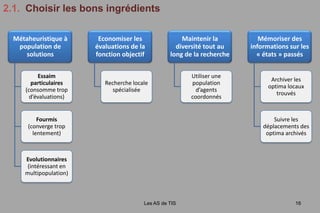

Le document présente les travaux de Julien Lepagnot sur le développement de l'algorithme d'optimisation dynamique Mado, sous la supervision d'un comité académique. Il explore l'optimisation statique et dynamique, ainsi que des métaheuristiques variées, tout en fournissant une analyse des performances de Mado. Les résultats montrent que Mado performe bien dans des contextes dynamiques, malgré quelques limitations avec certains types de fonctions, notamment celles à hauts multimodalités.

![1.3. Les métaheuristiques(2 / 4)Les AS de TIS8Exemple : Algorithmes évolutionnaires [Holland, 1973]COMPETITION entre agentsReposent sur la compétition au sens de DarwinPopulationcourantePopulation dedescendantsCroisementEvaluationSélectionMutationPopulation dedescendants mutésPopulationévaluée](https://image.slidesharecdn.com/julienlepagnot13112009-091121100555-phpapp01/85/Julien-Lepagnot-13-11-2009-9-320.jpg)

![1.3. Les métaheuristiques(3 / 4)Les AS de TIS9Exemple : Colonies de fourmis [Dorigo et al., 1996]INTELLIGENCE EN ESSAIM : COOPERATION INDIRECTE entre agents (via l’environnement)](https://image.slidesharecdn.com/julienlepagnot13112009-091121100555-phpapp01/85/Julien-Lepagnot-13-11-2009-10-320.jpg)

![1.3. Les métaheuristiques (4 / 4)Les AS de TIS10Exemple : Les essaims particulaires [Kennedy et Eberhart, 1995]INTELLIGENCE EN ESSAIM : COOPERATION DIRECTE entre agentsVers sa meilleureperformanceL’OEP simule le comportement social d’un essaim de « particules »A chaque itération t, chaqueparticule i se définit par :](https://image.slidesharecdn.com/julienlepagnot13112009-091121100555-phpapp01/85/Julien-Lepagnot-13-11-2009-11-320.jpg)

![sa vitesseω, c1, c2, coefficients de confiance et r1, r2Î ]0, 1]NouvellepositionPositionactuelleVers la meilleureperformance del’essaimVers le pointaccessible avec lavitesse courante](https://image.slidesharecdn.com/julienlepagnot13112009-091121100555-phpapp01/85/Julien-Lepagnot-13-11-2009-13-320.jpg)

](https://image.slidesharecdn.com/julienlepagnot13112009-091121100555-phpapp01/85/Julien-Lepagnot-13-11-2009-19-320.jpg)

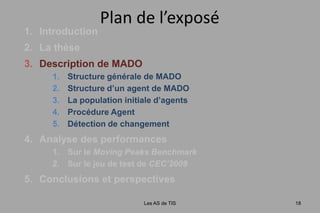

Plan de l’exposéIntroductionL’équipeL’optimisationLes métaheuristiquesL’optimisation dynamiqueLa thèseChoisir les bons ingrédientsMise au point d’une nouvelle métaheuristiqueDescription de MADOAnalyse des performancesConclusions et perspectivesLes AS de TIS15](https://image.slidesharecdn.com/julienlepagnot13112009-091121100555-phpapp01/85/Julien-Lepagnot-13-11-2009-21-320.jpg)

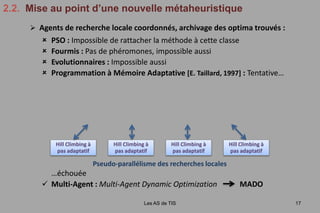

![Programmation à Mémoire Adaptative [E. Taillard, 1997] : Tentative……échouée](https://image.slidesharecdn.com/julienlepagnot13112009-091121100555-phpapp01/85/Julien-Lepagnot-13-11-2009-27-320.jpg)