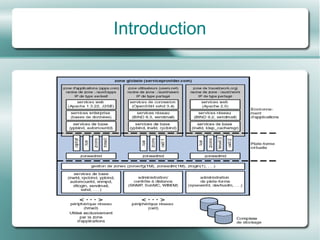

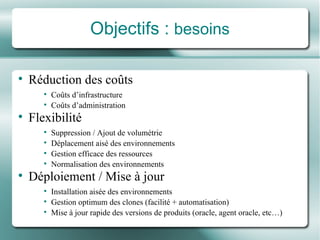

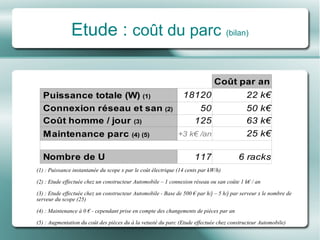

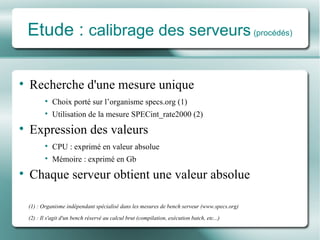

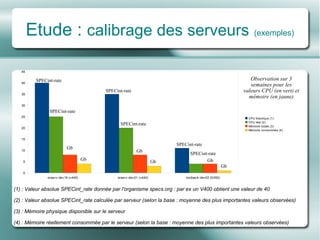

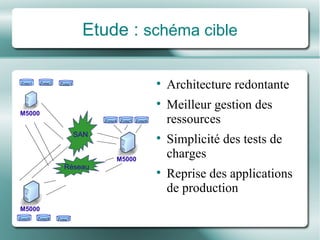

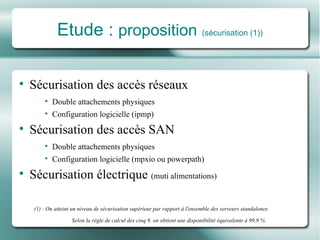

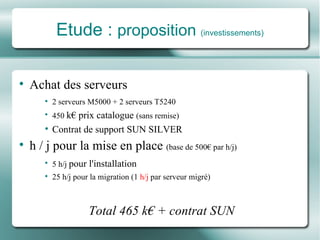

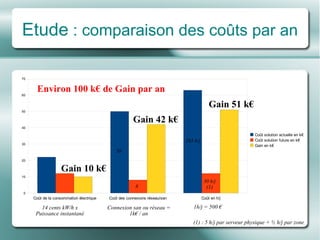

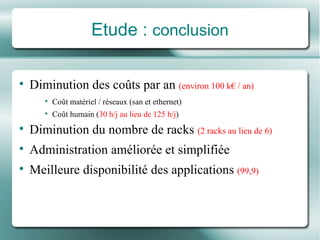

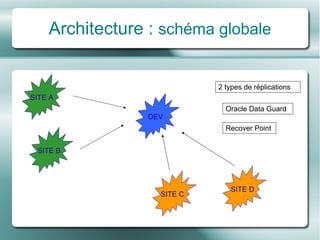

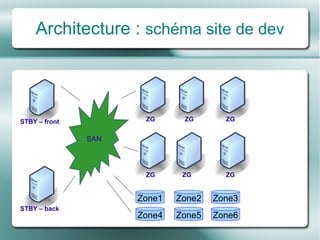

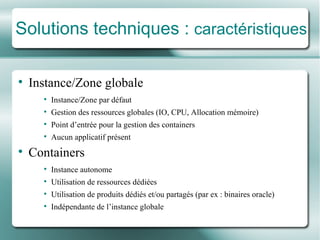

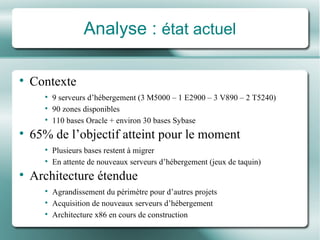

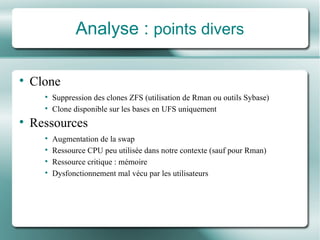

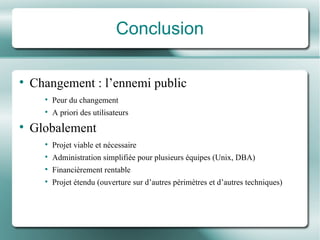

Le document présente une étude de mutualisation des serveurs visant à optimiser les coûts d'infrastructure et d'administration grâce à la virtualisation et à des solutions techniques adaptées. Une analyse approfondie des besoins, des architectures et des coûts a été réalisée, mettant en avant des gains significatifs sur les ressources et une amélioration de la disponibilité des applications. La conclusion souligne la viabilité du projet et les bénéfices d'une administration simplifiée pour plusieurs équipes.