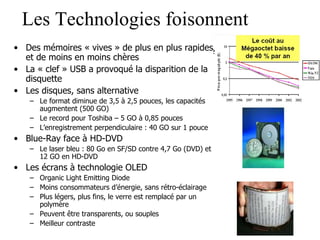

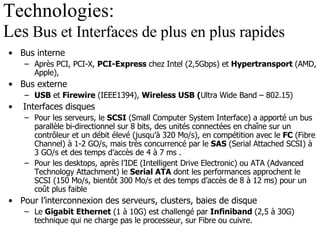

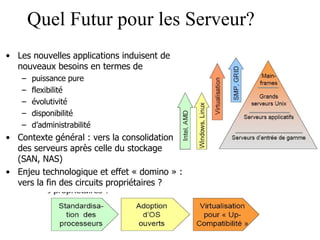

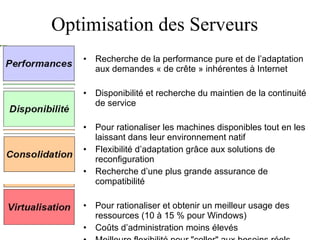

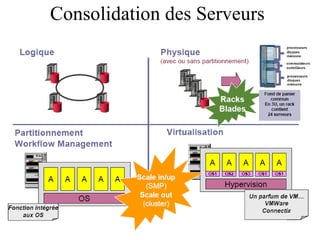

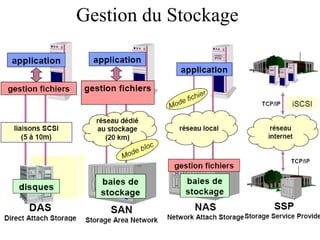

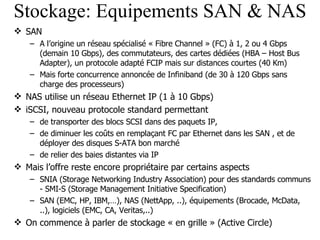

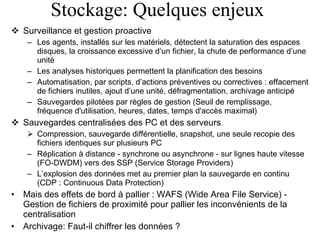

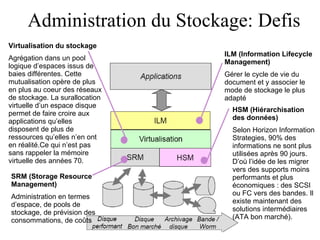

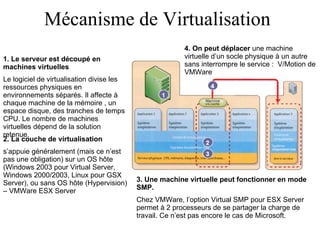

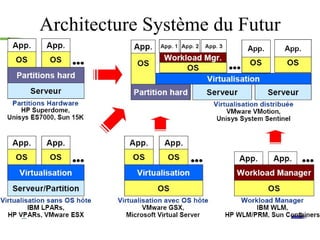

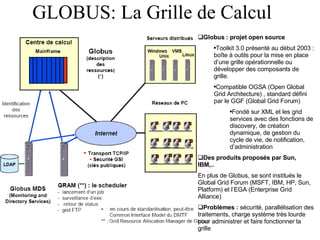

Le document examine les avancées technologiques dans les réseaux et systèmes informatiques, en mettant l'accent sur le stockage, la virtualisation, et les architectures serveurs. Il aborde la transition vers des dispositifs comme les disques SSD et le stockage en grille, tout en décrivant les défis d'administration et d'optimisation des ressources. L'importance croissante de la virtualisation et les conséquences des nouvelles normes de connectivité et de performance sont également soulignées.