Agents intelligents

- 1. Agents intelligents Badiâa Dellal-Hedjazi USTHB – Département d’Informatique 1

- 2. Motivations 1) Résolution des problèmes 2) Apprentissage automatique 3) Compréhension du langage naturel 4) Raisonnement automatique 5) Systèmes experts... Remarque: Ces systèmes sont renfermés sur leur raisonnement et ignorent tout de leur environnement Mais : L’intelligence n’est pas une caractéristique individuelle que l’on peut séparer du contexte social. 2 Domaines de l’IA Définition IA: La construction de programmes informatiques qui s’adonnent à des tâches qui sont, pour l’instant, accomplies de façon plus satisfaisante par des êtres humains. • L’intelligence est également le produit de l’interaction avec l’environnement. • Un comportement intelligent émerge de l’interaction de comportements plus simples. Définition de l’IA: L’IA est considérée comme la science de la conception d’agents intelligents.

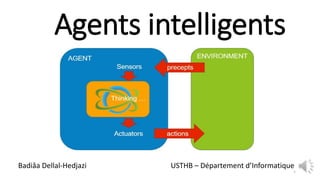

- 3. Le paradigme Agent Un agent est un système informatique situé dans un environnement qu’il peut percevoir et sur lequel il peut agir. Exemples: Agent logiciel: Agenda électronique Agent matériel: Robot 3

- 4. 4

- 5. Fonction et programme agent Le programme agent est une implémentation de la fonction agent. Il associe à la perception actuelle l’action adéquate. La fonction agent spécifie l’action qu’il exécute en réponse à une séquence de percepts donnée. Monde de l’aspirateur 2 salles, un robot aspirateur et de la saleté Actions: Droite ; Gauche ; Aspirer ; Rien 5

- 6. Rationalité des agents Le succès d’un agent est évalué par une mesure de performance: • une fonction objective mesurant la qualité d’un comportement de l’agent Exemple: Mesure de performance pour un agent aspirateur • le volume de saleté ramassée • le temps pris • l’électricité consommée, • le bruit produit, etc. Rationalité ≠ Omniscience (tout savoir avec des connaissances sans limite) 2) Agent autonome S’il est capable d’adapter son comportement aux changements dans l’environnement (capable d’apprendre, de planifier, de raisonner) 6 1) Un agent rationnel est un agent qui agit d’une manière lui permettant d’obtenir le plus de succès possible dans la réalisation des tâches qu’on lui a assignées.

- 8. PEAS : Voiture autonome 8

- 9. PEAS : Système de diagnostic médical ●Mesure de performance: Rétablissement des patients, Minimisation coûts. ●Environnement : Patient, hôpital, personnel ●Effecteurs: Affichage de questions, tests , diagnostics, traitements ●Capteurs : Entrée au clavier de symptômes, observations, réponses patient9

- 10. PEAS : Monde du Wumpus 10 Mesure de performance or +1000, mort -1000 -1 par un pas, -10 pour une flèche Environnement Puanteur dans les chambres adjacent au wumpus. Brise dans les chambres adjacentes à une fosse Scintillement si l’or est dans la chambre Le wumpus meurt si on lui tire une flèche de face On a une seule flèche On peut ramasser l’or dans la même chambre On peut lâcher l’or dans une chambre Senseurs: stench (puanteur), breeze (brise), glitter (scintillement), bumper (choc), scream (cri). Actuateurs (Effecteurs): : tourne gauche, tourne droite, avance, saisit, tire

- 11. Propriétés de l’environnement 1. Complètement observable vs Partiellement observable: L’agent perçoit l’état complet de l’environnement à tout moment. Ex. Jeux d’échecs : CO / Voiture autonome : PO 2. Déterministe vs Stochastique: Le prochain état de l’environnement est complètement déterminé par son état courant et l’action de l’agent ? Ex. Robot aspirateur : D / Voiture autonome : S 3. Épisodique vs Séquentiel: Un épisode est une seule séquence perception-action. Le prochain épisode ne dépend pas des actions effectuées dans les épisodes précédents. Ex. Détection pièces défectueuses dans une chaine de montage: E / Voiture autonome: S 4. Statique vs Dynamique: L’environnement ne change pas pendant que l’agent délibère. Ex. Agent de Mots-croisés : S / Voiture autonome : D 5. Discret vs Continu: La distinction discret/continu peut être appliquée à l’état de l’environnement, à la façon dont le temps est géré, et aux perceptions et aux actions de l’agent. Ex. Jeux d’échecs : D / Voiture autonome : C 6. Un agent vs Multi-agents : Est-ce qu’il y a plus qu’un agent interagissant ensemble ? Ex. Agent de Mots-croisés : A / Jeux d’échecs: M 11

- 12. Types d’agents •Agent réflexe simple (Simple reflex agent) •Agent réflexe avec état interne (Model-based reflex agent) •Agent basé sur les buts (Goal-based agent) •Agent basé sur l’utilité (Utility-based agent) •Agent apprenant (Learning agent) 12

- 14. Agent aspirateur réflexe 14 Problème : Boucle infinie

- 15. Agent réflexe avec état interne 15 Exemple: Peut résoudre un labyrinthe Avantage : Evite les boucles infinies

- 16. 16 Exemple: Peut résoudre n’importe quel labyrinthe. Avantage : On peut changer de but sans réécrire toutes les règles. Agent basé sur les buts function Goal-Agent (percept) return action Static: current world state rules State = update-state-(state, percept) Do { rule = rule-match(state; rules) action= rule-action(rule) state=update-state(state, action)} while (not goals?<-state) Return action Algorithme d’exploration ou de planification

- 17. Agent basé sur l’utilité 17 function Utility-Agent (percept) return action static : current world state rules State= update-state (state, percept) Do { rule = rule-match(state, rules) action = rule-action (rule) state= update=state(state-action) } while (not goals?<-state)||(not good quality) Return action Exemple: - Un agent avec buts peut trouver la sortie (but : succès ou échec) MAIS - un agent avec utilité peut trouver le chemin le plus court pour la sortie (degré de succès)

- 18. Agent apprenant Agent simple réflexe Agent réflexe avec état interne Agent basé sur l’utilité Agent basé sur le but Agent apprenant 18 Pour de nombreux problèmes (Reconnaissance faciale, robot à très haut degré de complexité), il est très difficile de spécifier explicitement le comportement de l’agent à la conception. Concevoir des agents apprenants. L’apprentissage permet: – de simplifier la conception – à l’agent d’avoir plus de flexibilité – à l’agent d’agir dans des environnements inconnus et devenir meilleur avec le temps.

- 19. Avantage : Capable de modifier ou d’améliorer son comportement en fonction de ses expériences précédentes. Module de performance • Connaissances et procédures pour choisir les actions. (constituait la totalité de l’agent) Critique • Observe l’agent et donne des informations au module d’apprentissage. Module d’apprentissage • Modifie le module de performance. Générateur de problèmes • Identifie les possibilités d’amélioration et suggère des expérimentations. 19

- 20. Agent taxi apprenant Module de performance • Le taxi fait des actions sur la route comme tourner subitement à gauche. Critique • Observe le mécontentement des autres conducteurs; il avertit alors le module d’apprentissage. Module d’apprentissage • Élabore une règle qui améliore les actions et le module de performance est modifié pour une autre règle. Générateur de problèmes • Détecte un besoin d’amélioration est suggère d’expérimenter d’autres façons de faire sur d’autres conditions de la route ( ex. conduite sur la neige) 20

- 21. Architectures d’agents Agent réactif Agent cognitif Simple. Ne possédant pas de représentation explicite de son environnement Dispose d’une capacité de raisonnement sur une base de connaissances Doté d’un comportement primitif (Stimulus/Action) Dispose d’aptitudes à traiter des informations diverses en interaction avec d’autres agents Une société d’agents réactifs fait émerger un comportement global intelligent. (ex. Colonie de fourmis) Des capacités décisionnelles (ex. Robot planificateur) 21

- 22. Agent réactif : Architecture de Subsomption Fondée sur des couches organisées par priorité de bas en haut en modules à comportement limité. Exemple: Un robot d’exploration de la planète Mars M0 : Module pour éviter les obstacles ; M1 : Module de déplacement dans l'environnement tout en évitant les obstacles avec M0 ; M2 : Module qui a la compétence supérieure, la plus abstraite, de faire l'exploration de la planète en se déplaçant grâce aux actions du module M1. 22

- 23. Agent cognitif : Architecture BDI (Belief, Desire, Intention) 23 Croyance: Informations sur l’environnement Désirs: Etat final désiré Intention: Actions à faire pour réaliser désir Mécanisme de contrôle d’un agent BDI : ‒ Perception des modifications dans l’environnement. ‒ Mise à jour des croyances ‒ Prise en compte des désirs à satisfaire ‒ Production d’intentions génératrices d’actions dans l’environnement.

- 24. Exemple agent BDI: Système de contrôle du trafic aérien OASIS (Aéroport de Sydney – Australie ) 24

- 25. Quelques applications • Finance : Agent investisseur • Robotique: explorer, éviter les obstacles, plus court chemin • Jeux : Jeux d’échecs • Recherche d’information : crawler ( robot d’indexation) • Veille et recommandation : Recommandation de produits • Traitement du langage naturel : Traduction automatique • Analyse d’images : Satellite, médicales • E-learning: Tuteur interactif, apprentissage langue, ... 25

- 26. Pour chacun des exemples d’agents suivants, dites quel type d’agent et le plus approprié (simple réflexe, réflexe avec état interne, but et utilité) a. Un agent contrôlant une valve de pression d’une centrale nucléaire. b. Un agent devant sortir d’un labyrinthe. c. Un agent conduisant une automobile. d. Un agent qui achète et vend des actions sur internet. e. Un agent qui nettoie la vaisselle et la range dans les armoires. Exercice 26