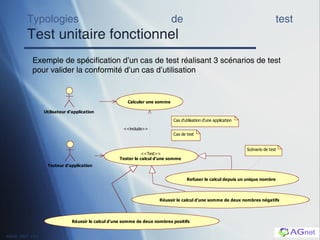

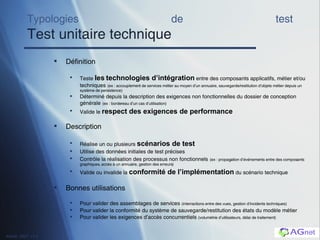

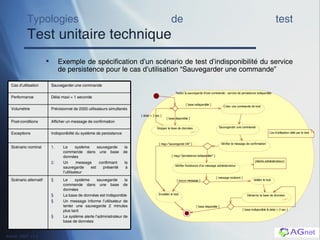

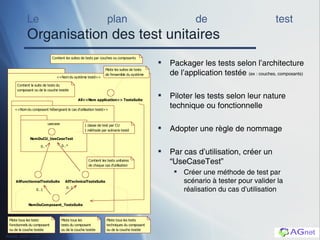

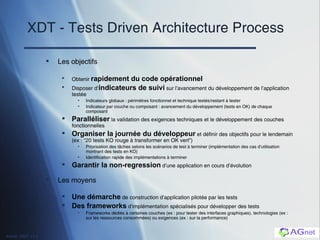

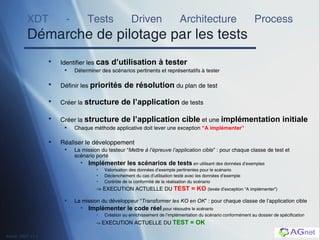

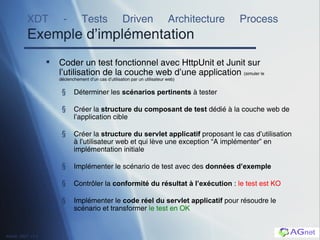

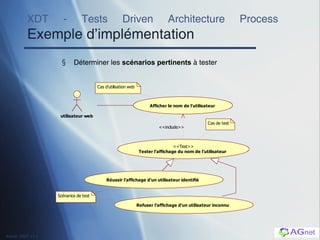

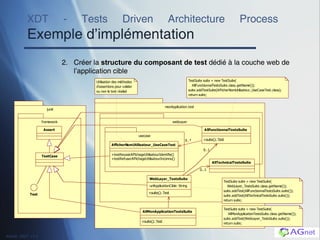

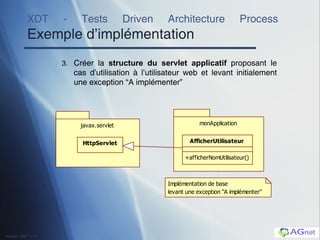

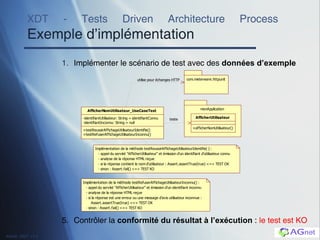

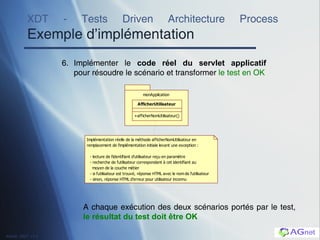

Le document présente un processus d'architecture pilotée par les tests (TDAP) visant à améliorer la qualité logicielle par des tests fonctionnels et techniques. Il décrit les typologies de tests, l'organisation d'un plan de test, ainsi que des exemples d'implémentation, en mettant l'accent sur la validation des exigences fonctionnelles et techniques. L'approche préconise une intégration efficace des tests dans le développement pour garantir la conformité et prévenir les régressions.