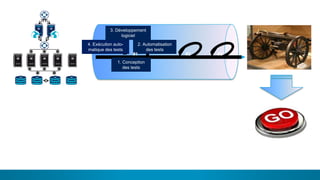

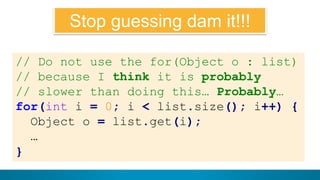

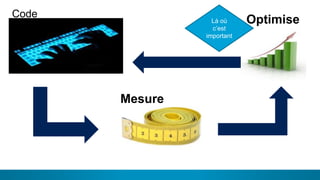

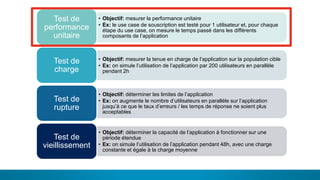

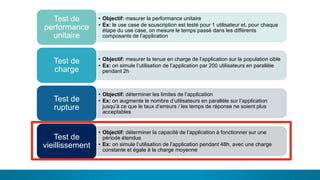

Le document détaille différents types de tests de performance nécessaires dans le développement informatique, notamment les tests unitaires, de charge, de rupture et de vieillissement. Chaque type de test a des objectifs spécifiques pour mesurer la performance d'une application sous différentes conditions d'utilisation. Il met également en avant l'importance de la mesure de performance tout au long du processus de développement.