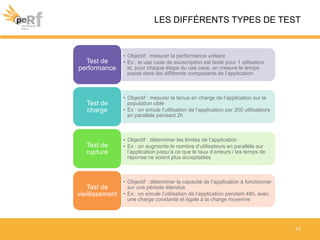

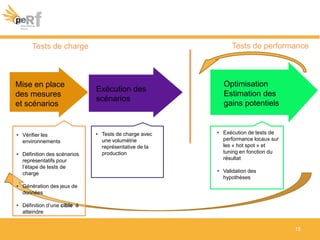

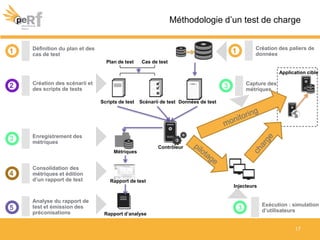

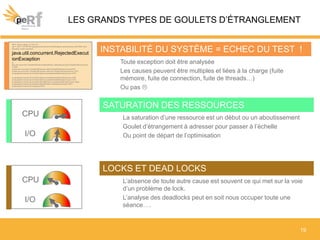

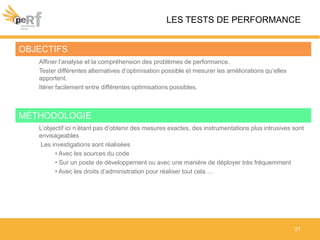

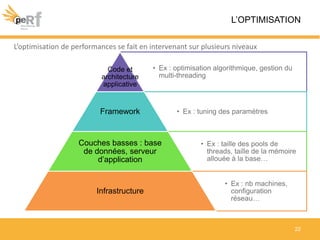

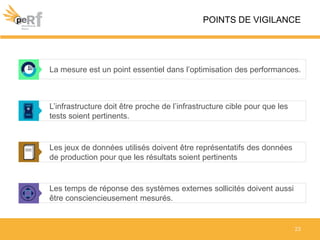

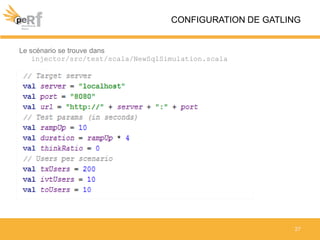

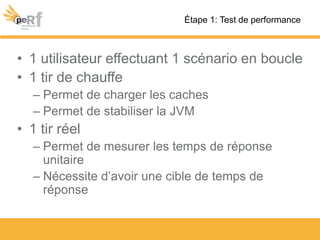

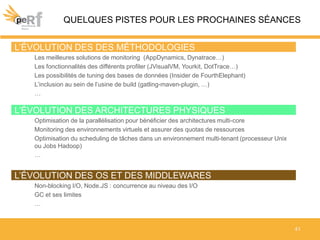

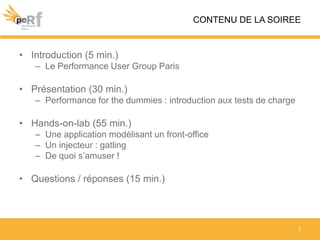

Le document présente un atelier sur les tests de performance, mettant en avant l'importance de mesurer les temps de réponse et la charge d'un système applicatif. Il aborde différentes méthodologies de tests, y compris les tests de performance, tests de charge, et tests de rupture, ainsi que des outils pour optimiser ces performances comme Gatling. L'atelier inclut également des exemples pratiques et des discussions sur les défis et les meilleures pratiques en matière de performance.

![Wikipedia

« [Les tests de performance] vont avoir pour objectif

de mesurer les temps de réponse d'un

système applicatif en fonction de sa

sollicitation. Cette définition est donc très

proche de celle de test de charge où l'on

mesure le comportement d'un système en

fonction de la charge d'utilisateurs simultanés.

Seuls les tests de charge permettent de valider

correctement une application ou un système

avant déploiement, tant en Qualité de Service

qu'en consommation de ressources. »

4

BIENVENUE AU PERFORMANCE USER GROUP

Larousse

Résultat chiffré (en temps

ou en distance) d'un

athlète ou d'un cheval à

l'issue d'une épreuve.

La performance d’un

système informatique

est caractérisée par les

temps de traitement

dans un contexte et

sous une sollicitation

donnés.](https://image.slidesharecdn.com/performanceug1-130521170511-phpapp01/85/Performance-ug-1-4-320.jpg)