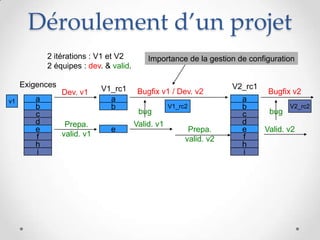

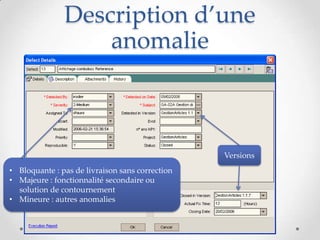

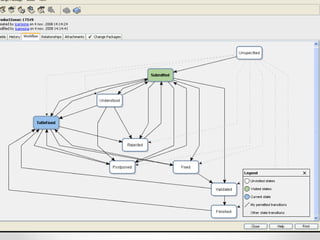

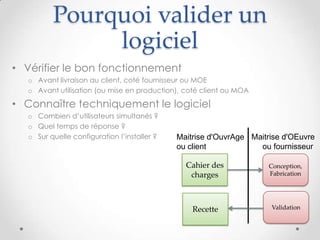

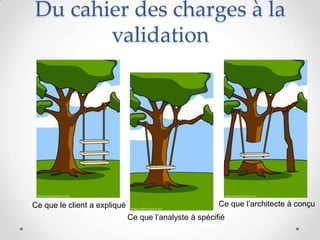

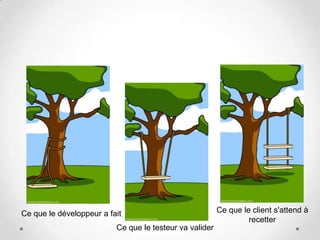

Ce document traite de la validation des logiciels, abordant son importance, les responsabilités des développeurs et validateurs, ainsi que les types de tests et les outils nécessaires pour une validation efficace. Il décrit également le processus de préparation, de déroulement d'une campagne de tests et le cycle de vie des anomalies. Enfin, il fournit des exemples concrets d'exigences et de cas de tests afin d'assurer une validation réussie.

![Exemple d'exigences

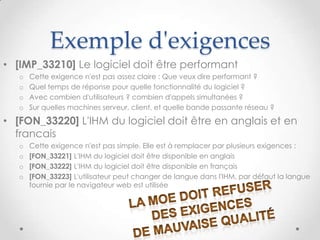

• [IMP_33210] Le logiciel doit être performant

o Cette exigence n'est pas assez claire : Que veux dire performant ?

o Quel temps de réponse pour quelle fonctionnalité du logiciel ?

o Avec combien d'utilisateurs ? combien d'appels simultanées ?

o Sur quelles machines serveur, client, et quelle bande passante réseau ?

• [FON_33220] L'IHM du logiciel doit être en anglais et en

francais

o Cette exigence n'est pas simple. Elle est à remplacer par plusieurs exigences :

o [FON_33221] L'IHM du logiciel doit être disponible en anglais

o [FON_33222] L'IHM du logiciel doit être disponible en français

o [FON_33223] L'utilisateur peut changer de langue dans l'IHM, par défaut la langue

fournie par le navigateur web est utilisée

9cc-by-sa Jean-Paul Carmona](https://image.slidesharecdn.com/validationlogiciel-121203093314-phpapp02/85/Introduction-a-la-validation-de-logiciel-9-320.jpg)