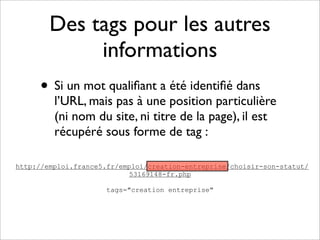

Le projet Ipination de 2010 vise à analyser et classifier les URLs en extrayant des informations sans nécessiter de crawling. Il utilise une taxonomie basée sur l'auteur du contenu, prenant en compte divers aspects tels que le type de site et la langue. À l'issue de l'analyse, un minimum d'informations est disponible, y compris le nom du site et plusieurs tags, permettant d'affiner la classification des URLs ultérieurement.