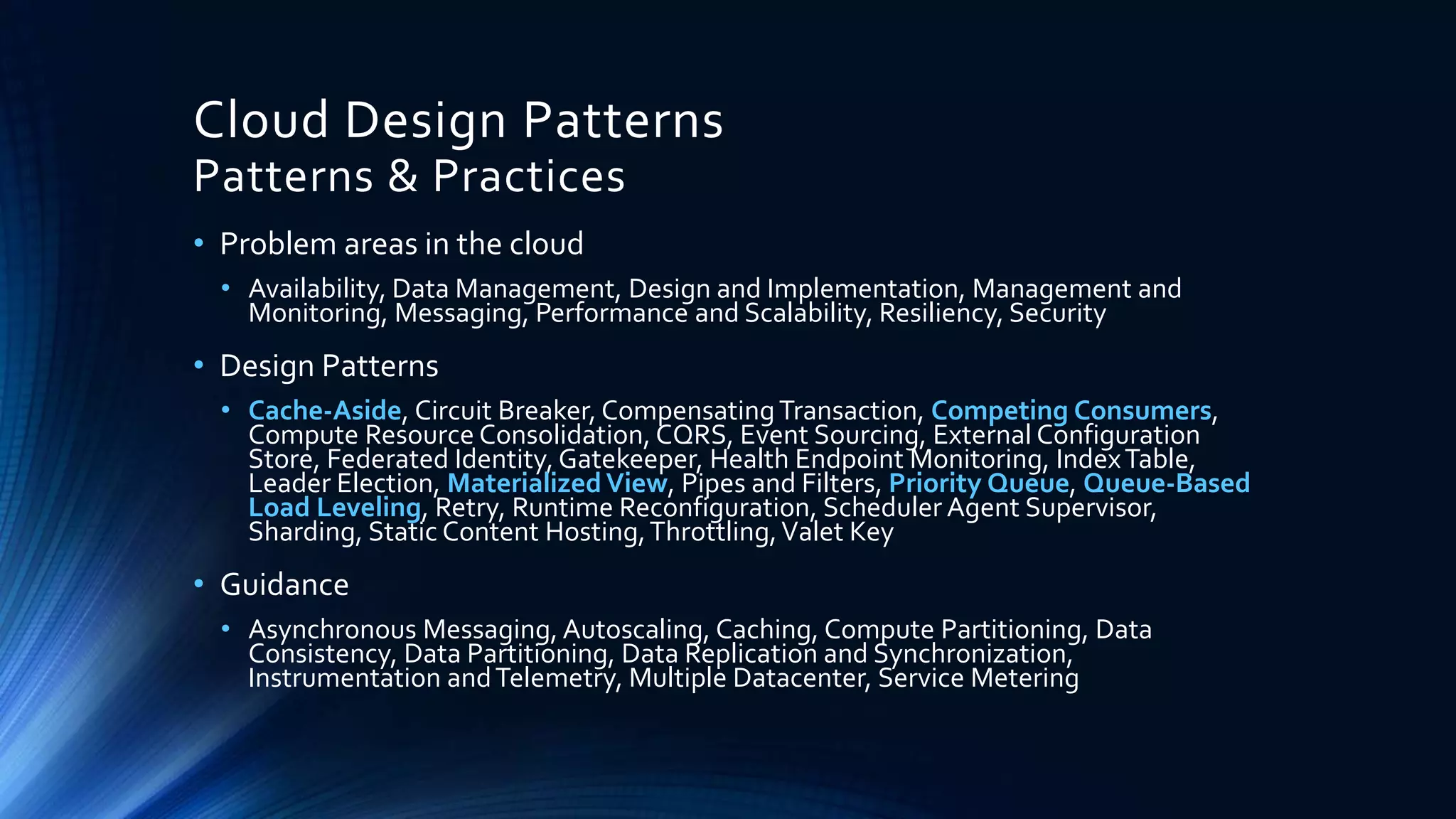

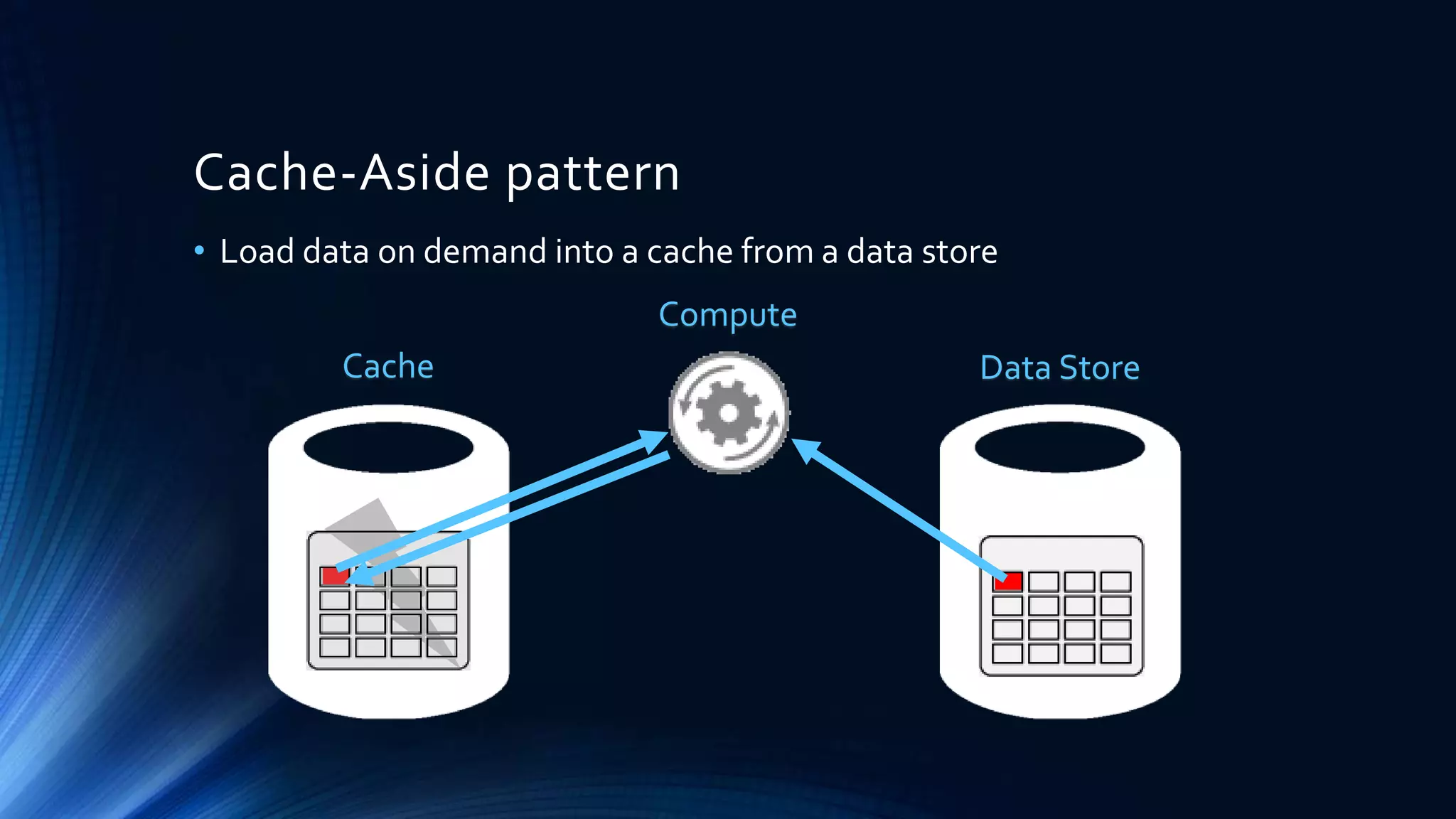

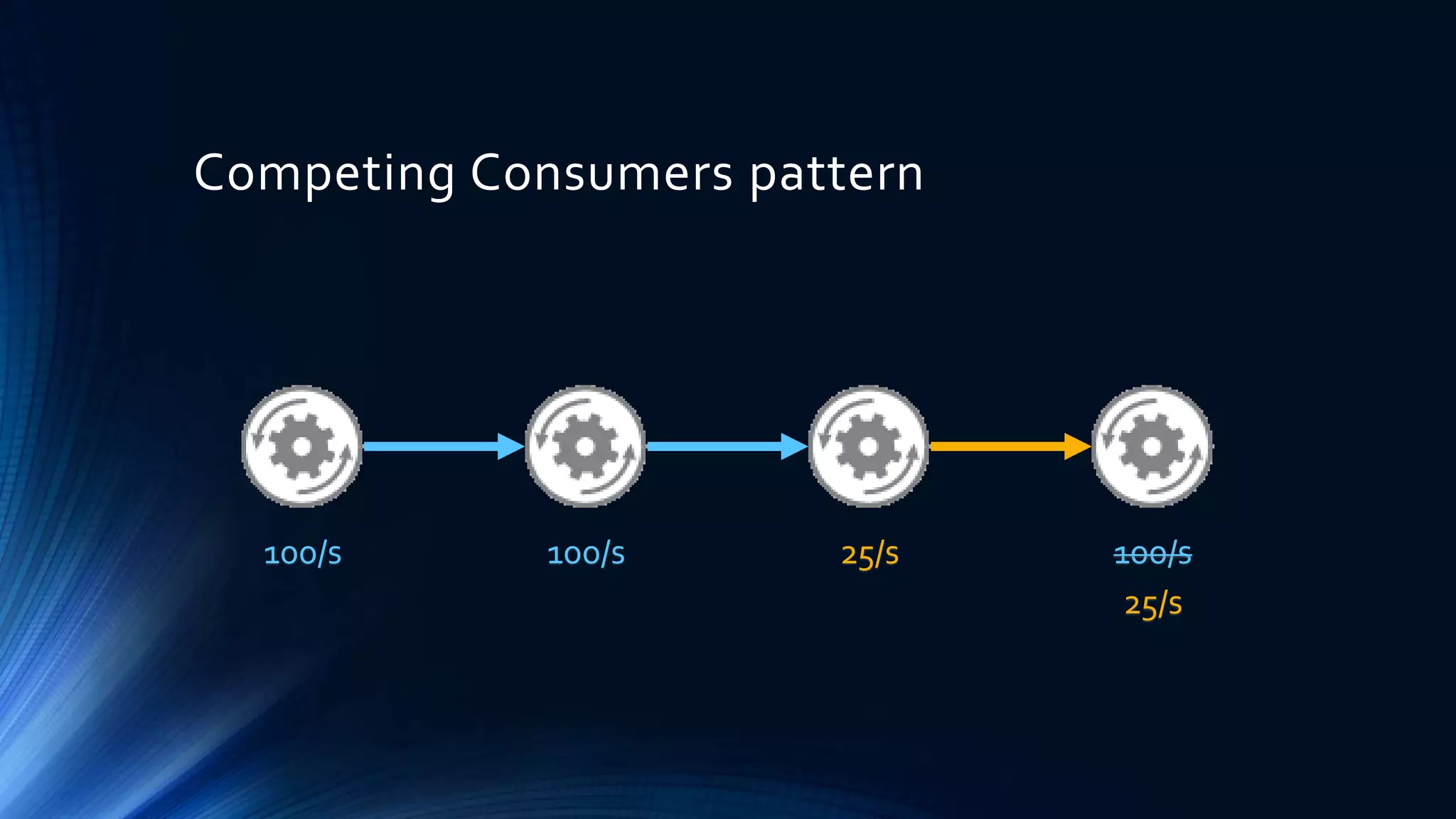

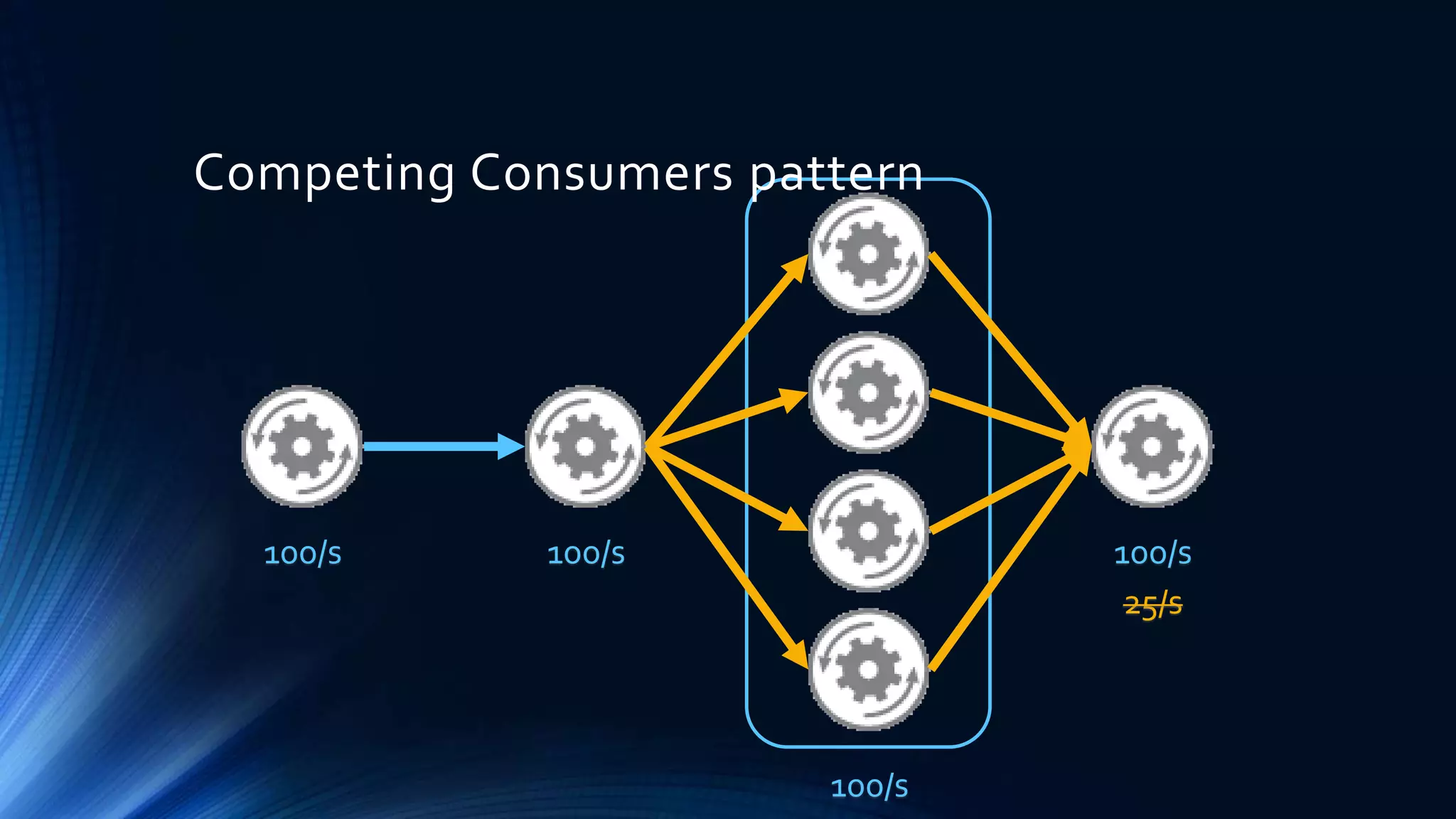

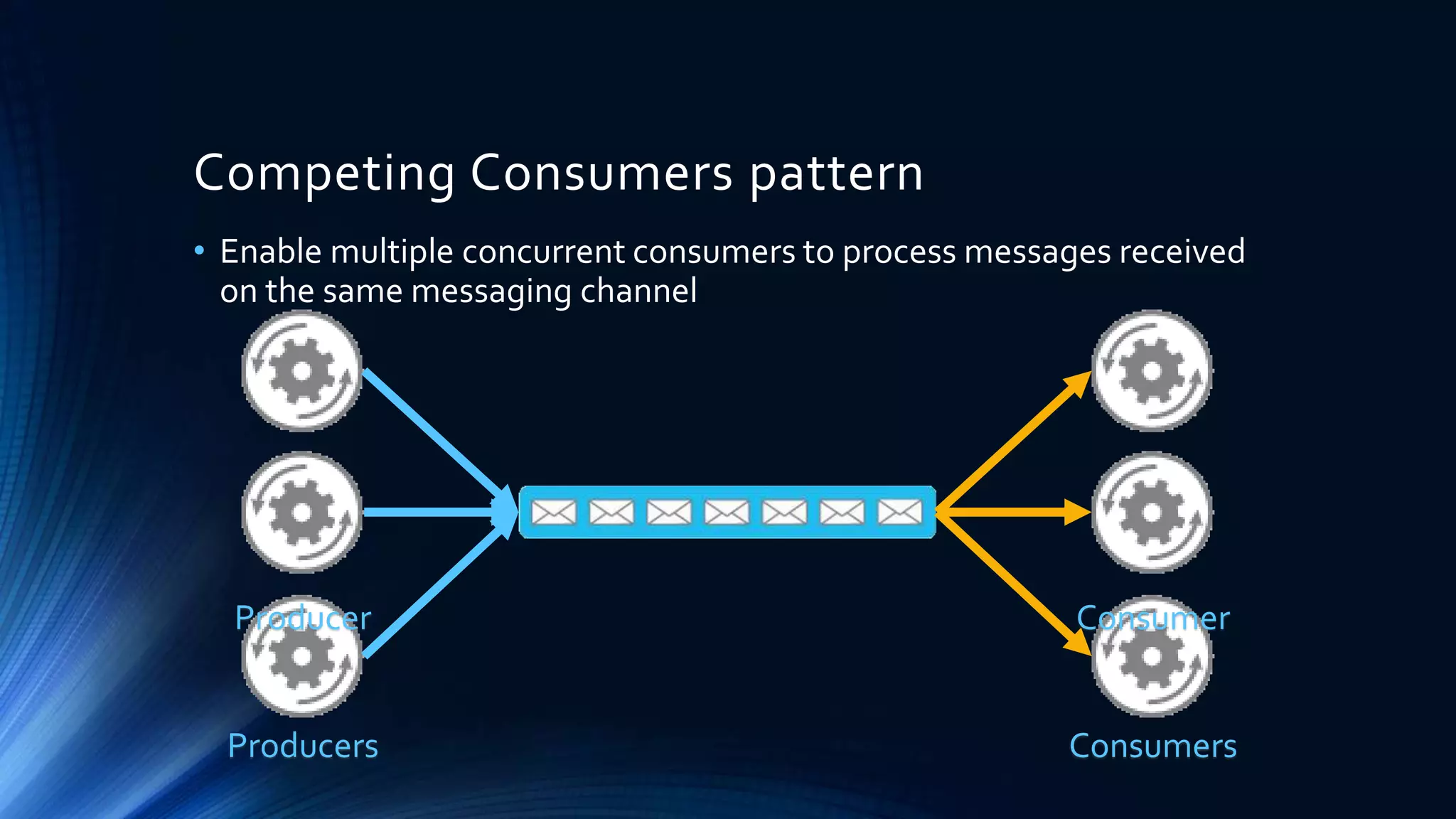

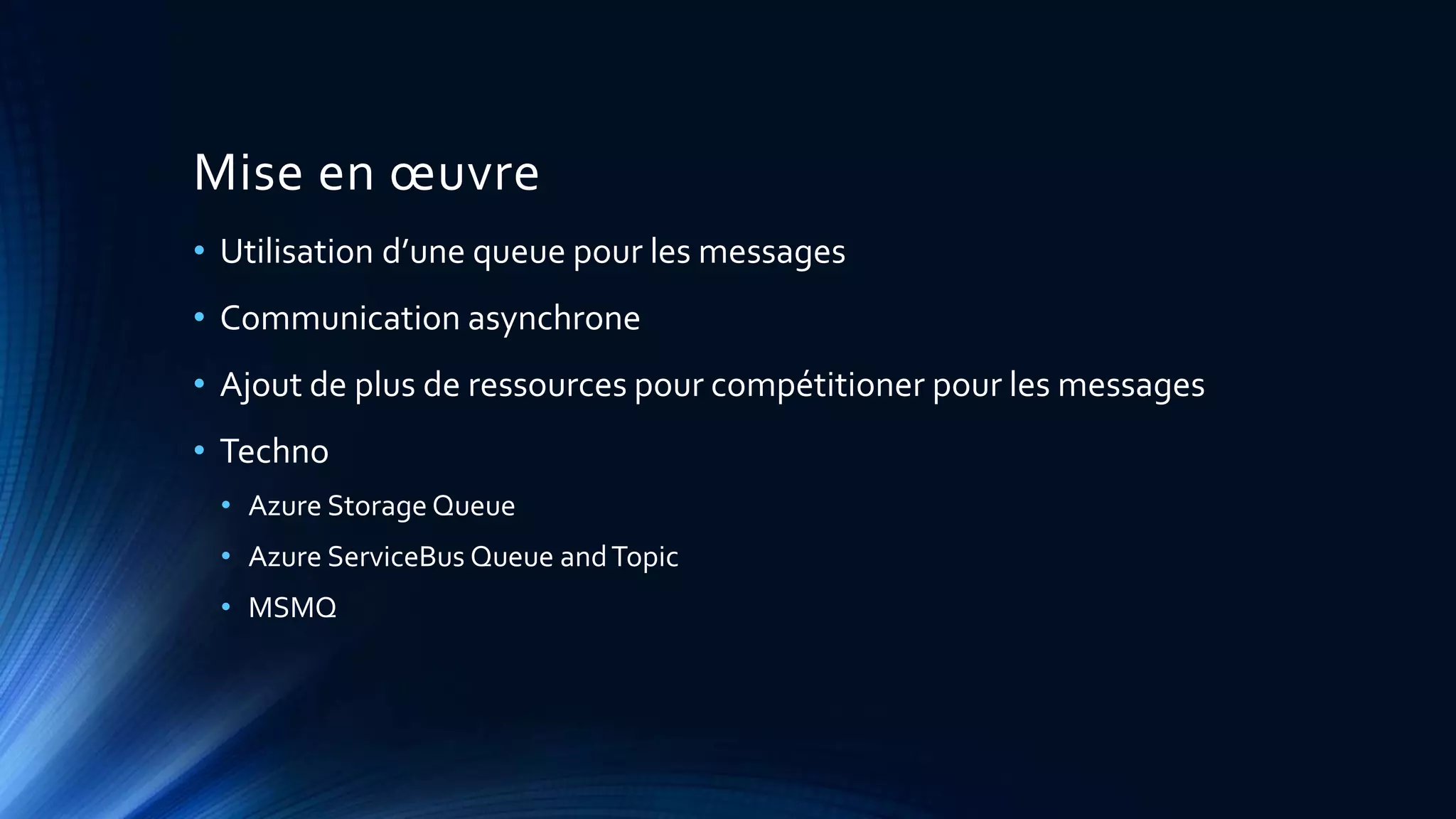

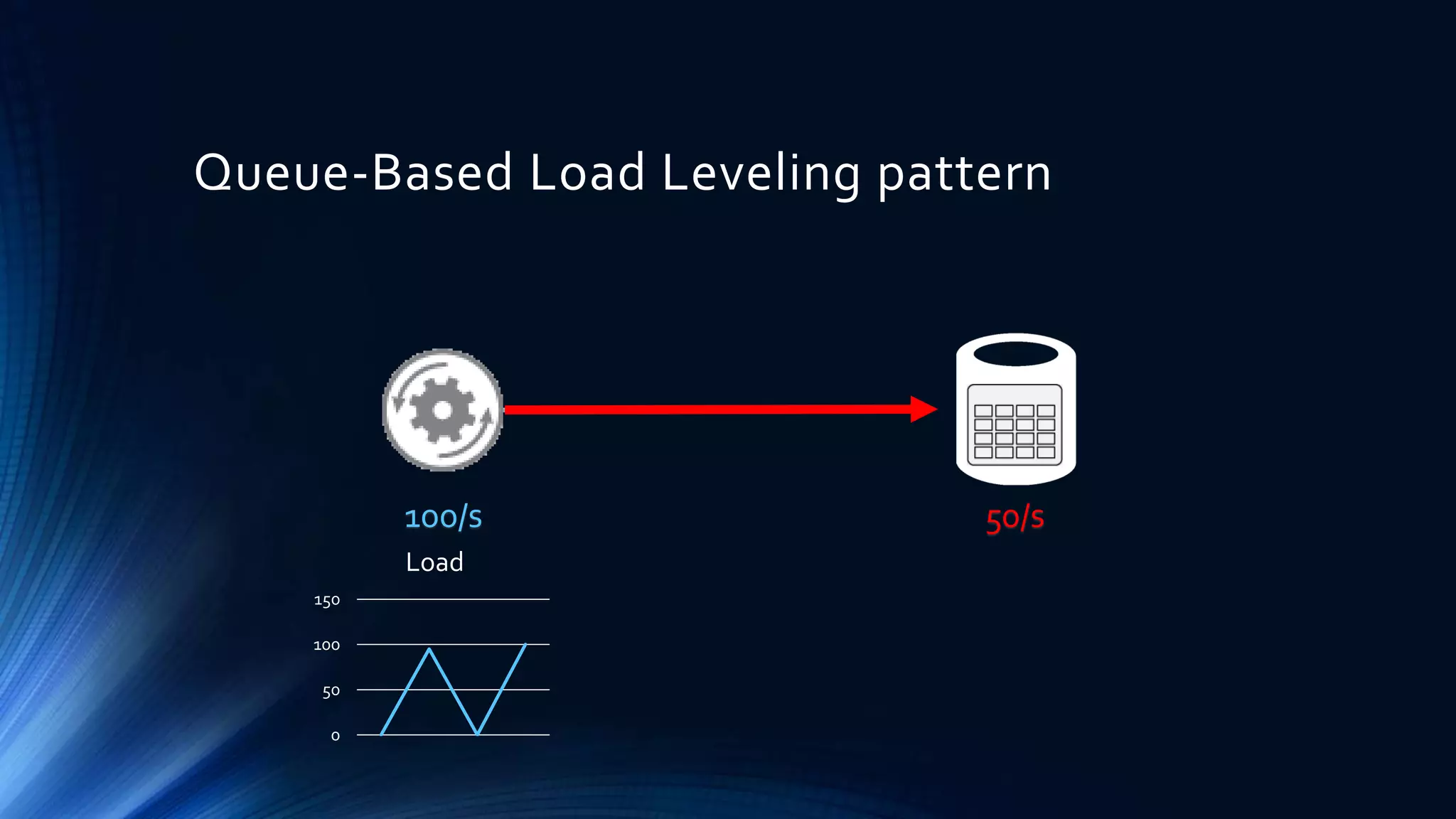

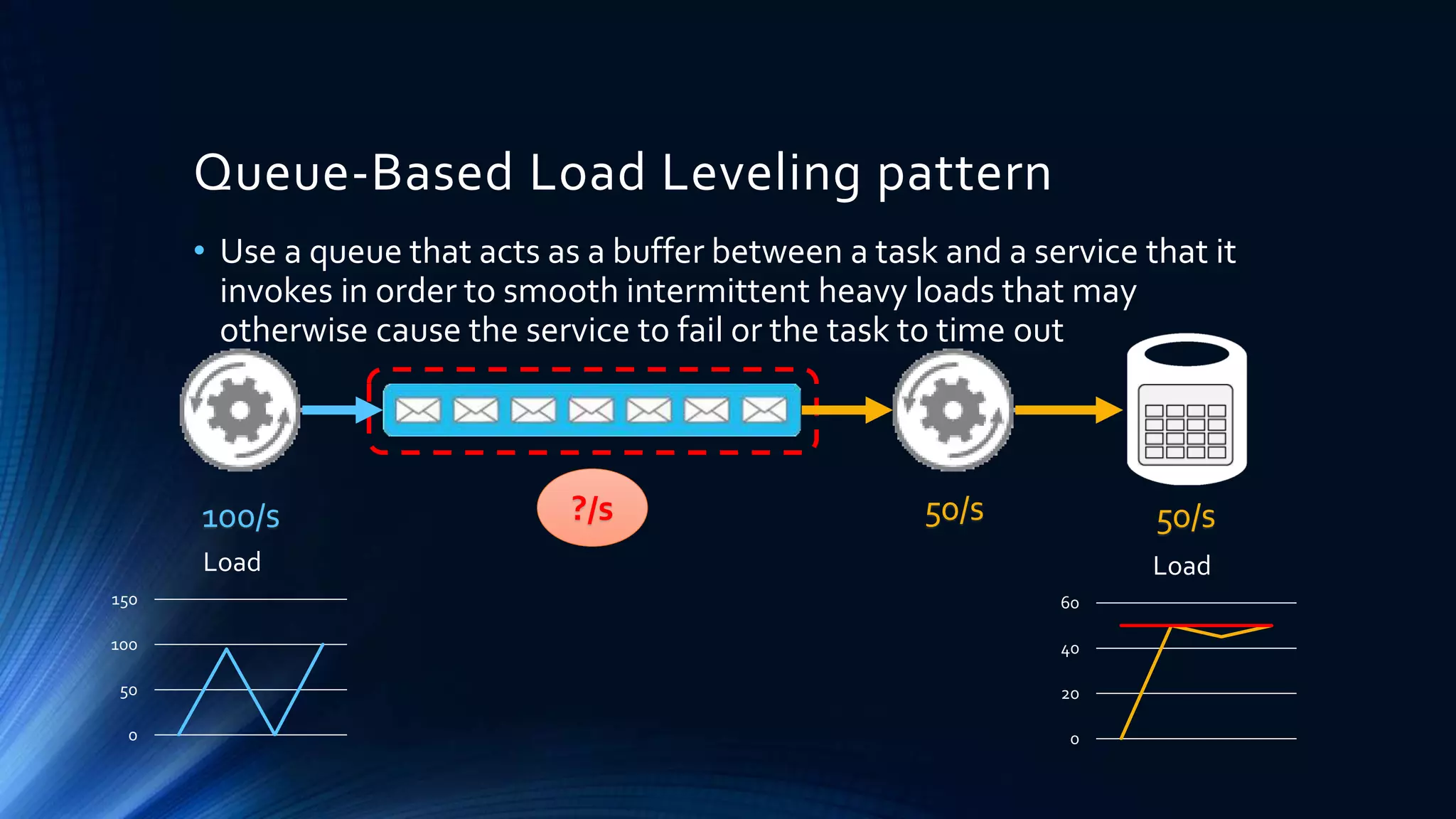

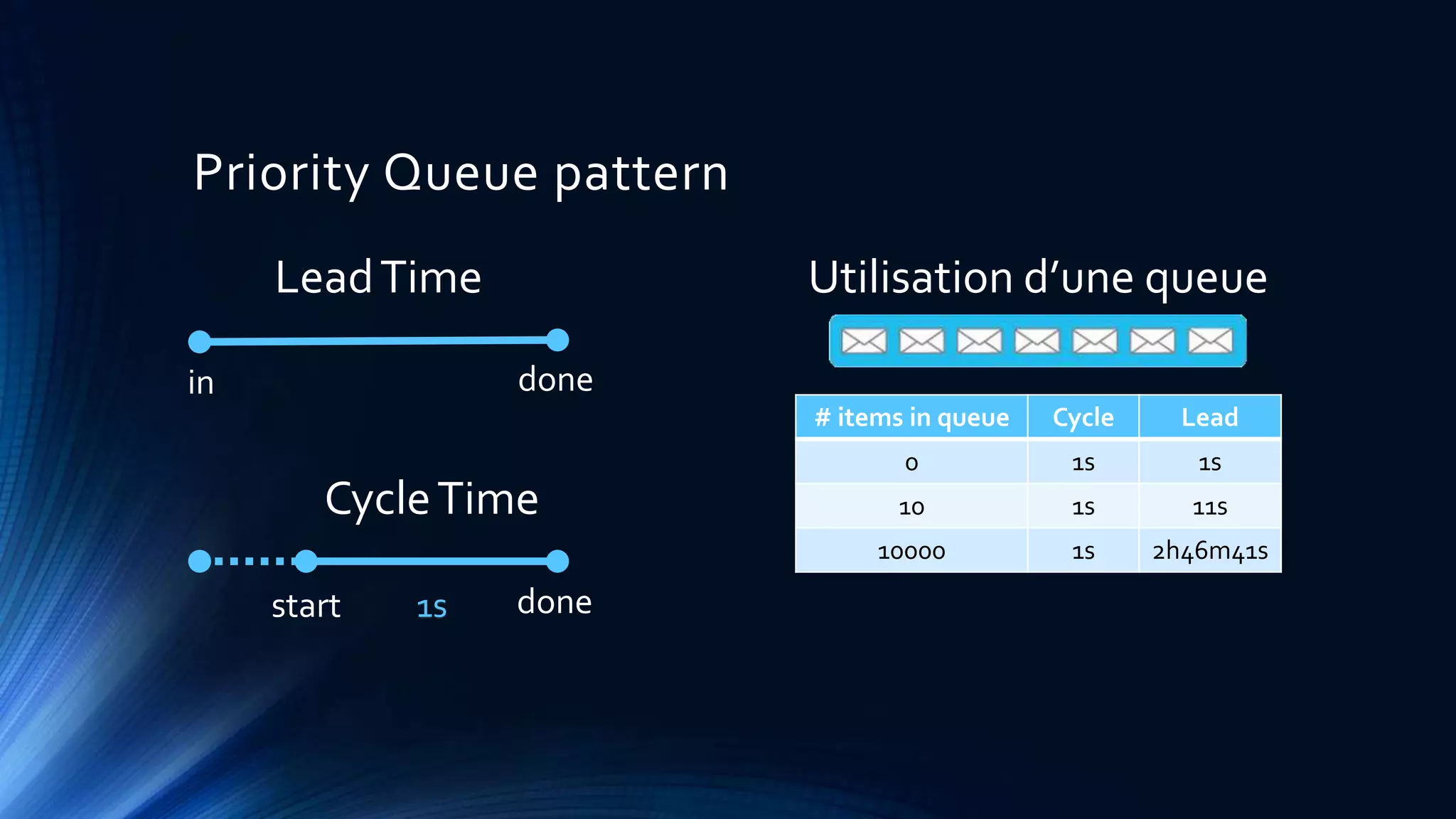

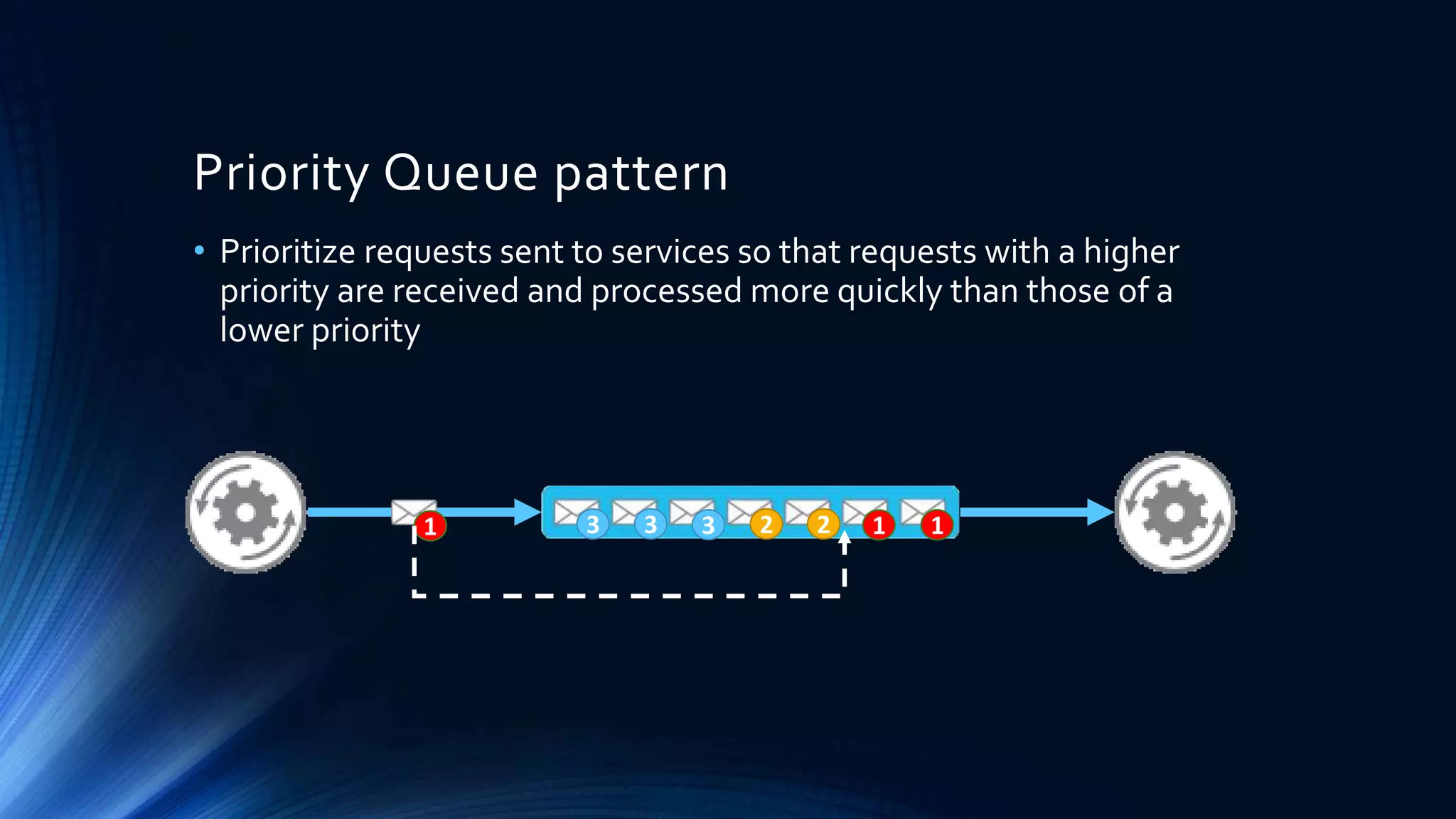

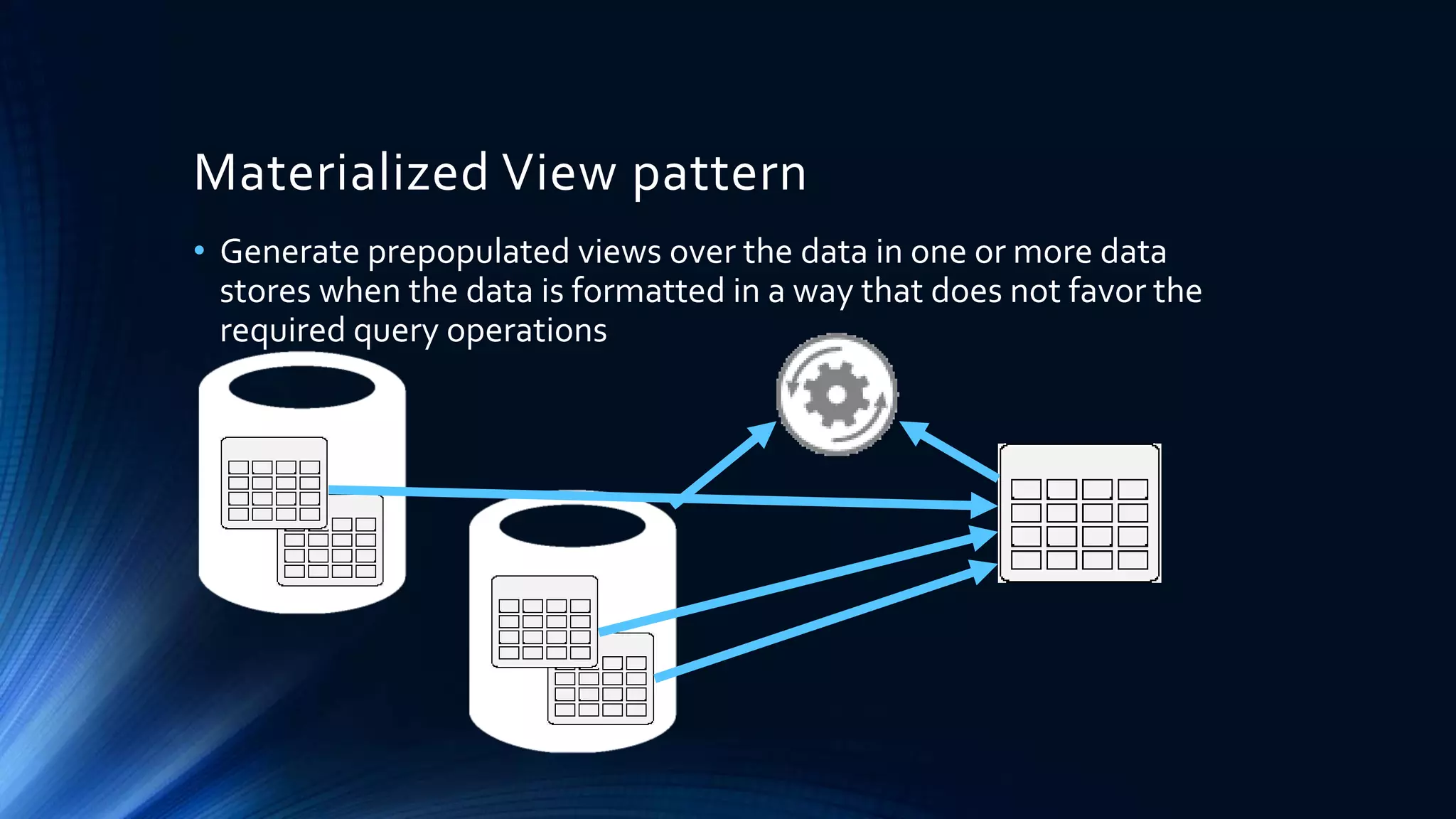

Ce document présente divers design patterns appliqués au cloud, mettant l'accent sur des problématiques telles que la disponibilité, la gestion des données et la sécurité. Des patterns spécifiques comme cache-aside, competing consumers et priority queue y sont décrits, avec leurs avantages et considérations techniques. L'accent est mis sur l'importance de comprendre les concepts de design, indépendamment des patterns, pour une application efficace dans le développement cloud.