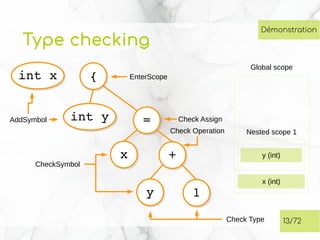

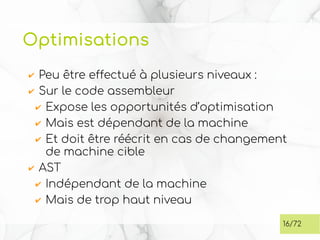

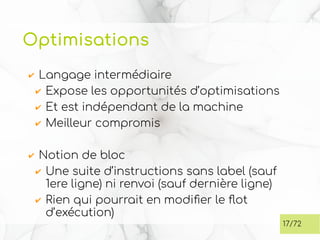

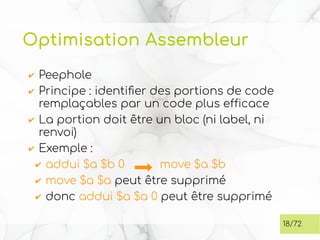

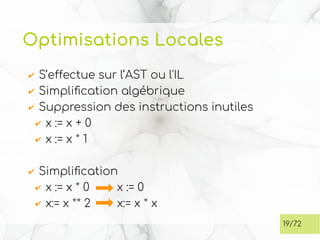

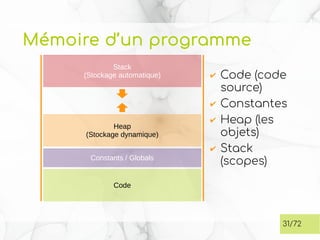

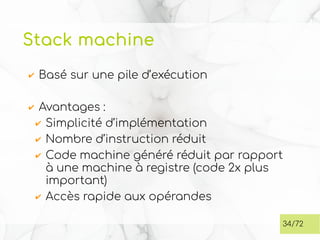

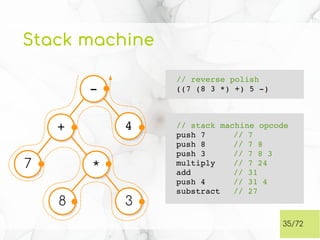

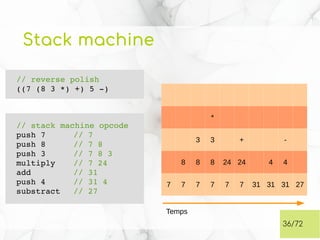

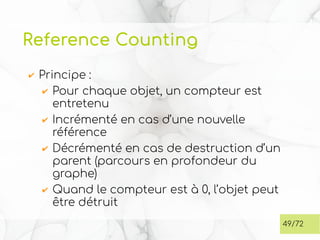

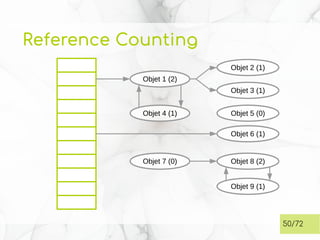

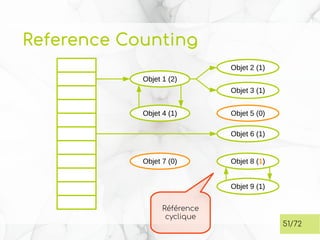

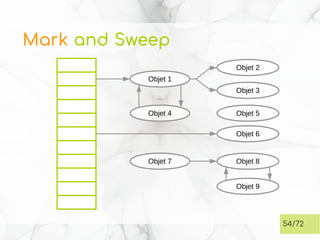

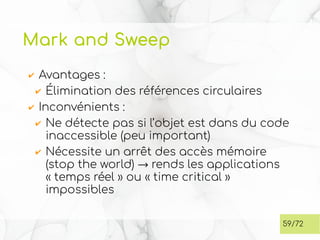

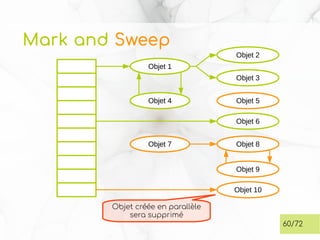

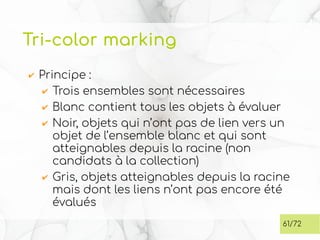

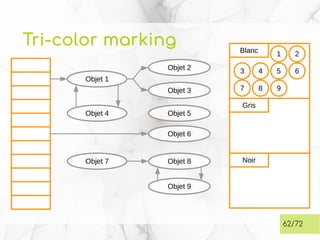

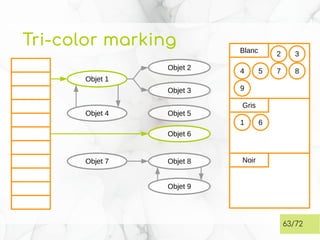

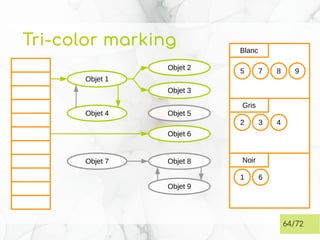

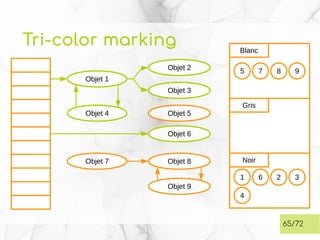

Le document traite de l'analyse sémantique et des optimisations dans la génération de code, en mettant l'accent sur le type checking et la gestion des symboles. Il aborde également les techniques d'optimisation, la mémoire des programmes et la gestion automatique de la mémoire avec un focus sur le garbage collector, incluant les algorithmes de référence et mark and sweep. En conclusion, il note que les langages compilés à la volée comme Java et C# peuvent surpasser C++ en termes de performances grâce à leurs capacités d'optimisation avancées.

![Type Checking

✔ Définition d’un type de variable :

✔ Ensemble des valeurs possible d’une

variable

ex : [0-9]+

✔ Ensemble des opérations possibles sur

ces valeurs

ex : +, -, /, *, %

✔ Les Classes sont une notion moderne des

types

ex : Surcharge des opérateurs C++

6/72](https://image.slidesharecdn.com/02-codegen-181108163757/85/Theorie-des-langages-02-Code-gen-6-320.jpg)