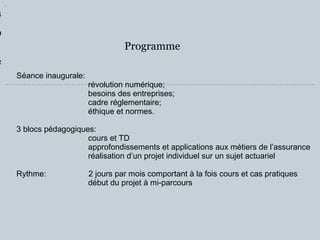

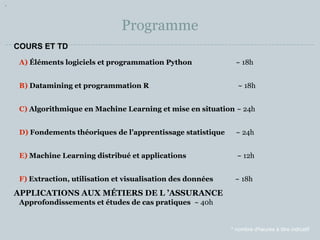

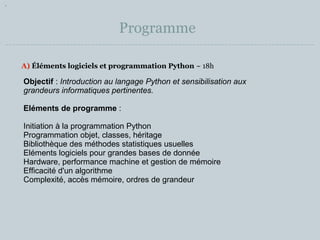

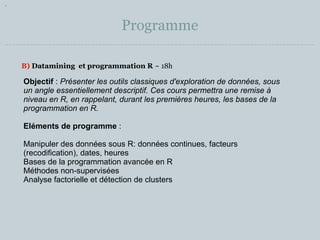

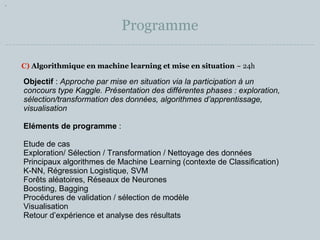

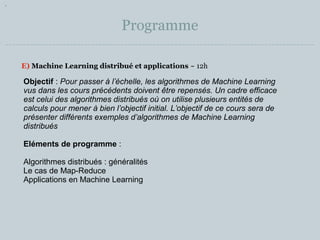

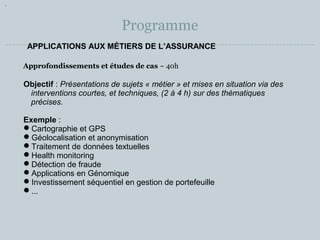

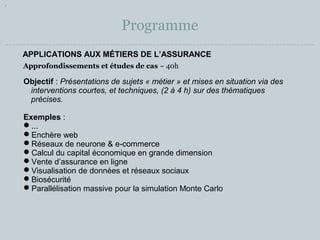

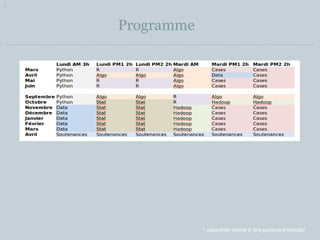

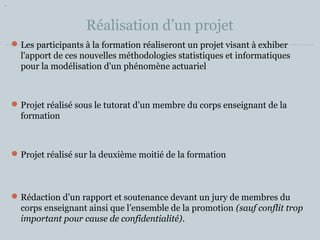

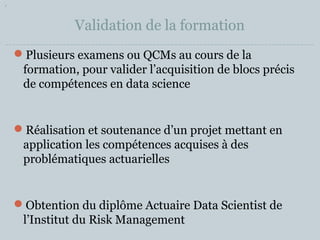

Le document présente un programme de formation pour devenir actuaire data scientist, débutant en septembre 2014, comprenant divers modules sur la programmation, le datamining, et le machine learning. La formation se déroule sur plusieurs mois avec des cours théoriques et des projets pratiques, visant à appliquer des compétences en data science à des problématiques actuarielle. Les participants devront réaliser un projet avec soutenance et passer des examens pour obtenir le diplôme de l'institut du risk management.