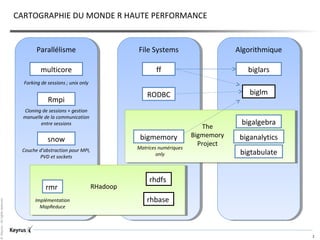

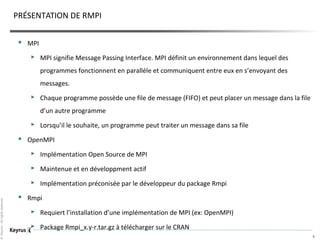

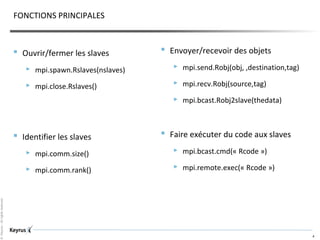

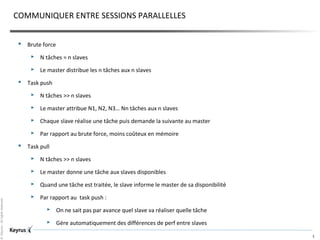

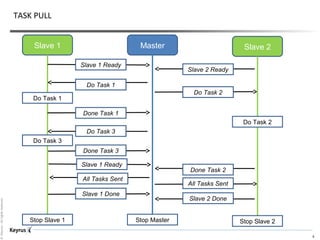

Le document présente le package Rmpi, qui utilise l'interface MPI pour la parallélisation et les calculs haute performance en R. Il explique les principales fonctions pour la communication entre sessions parallèles, ainsi que différentes stratégies de gestion des tâches. Enfin, le document souligne la flexibilité et la performance de la solution, malgré un besoin de développement plus important comparé à d'autres alternatives.