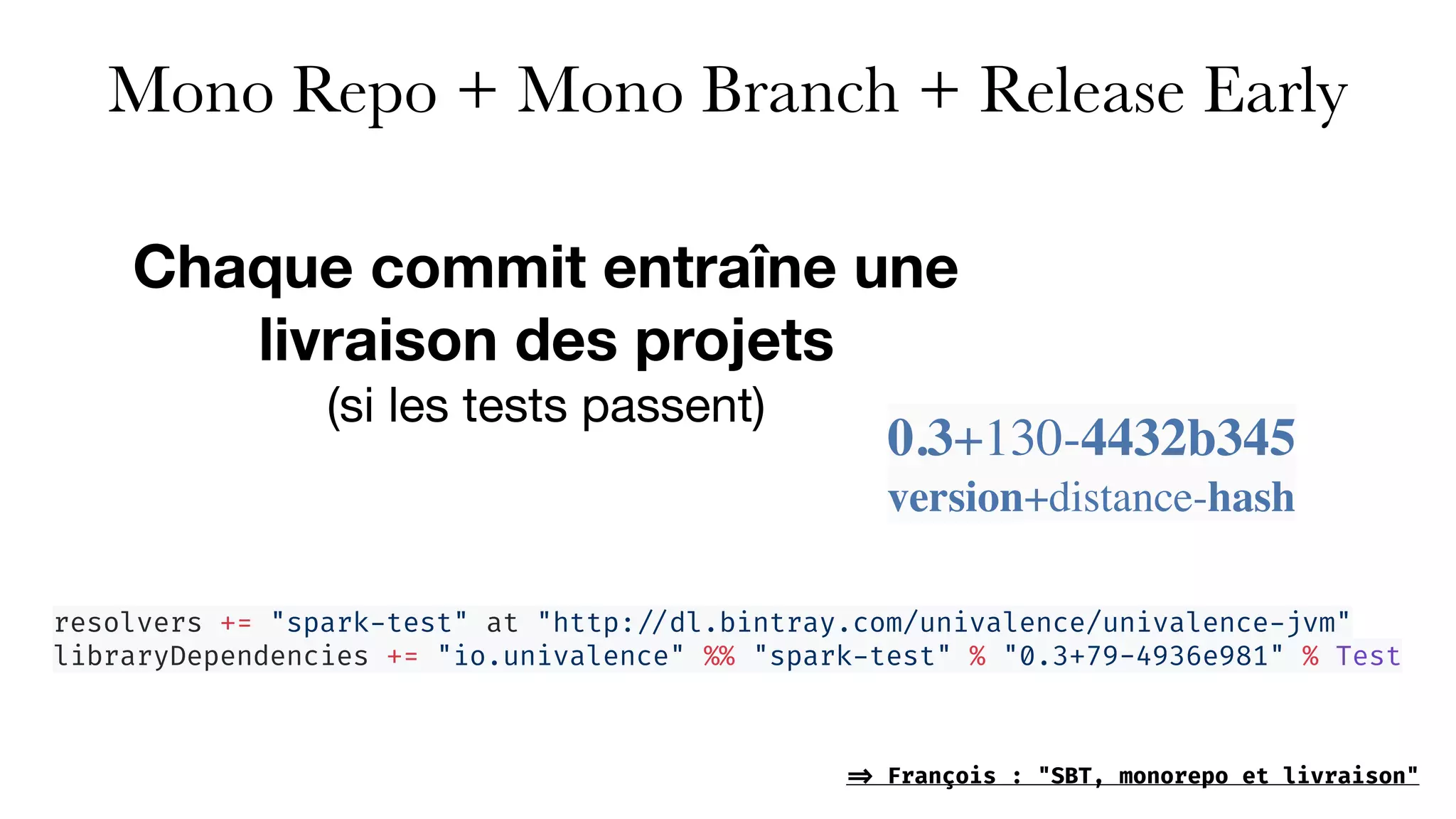

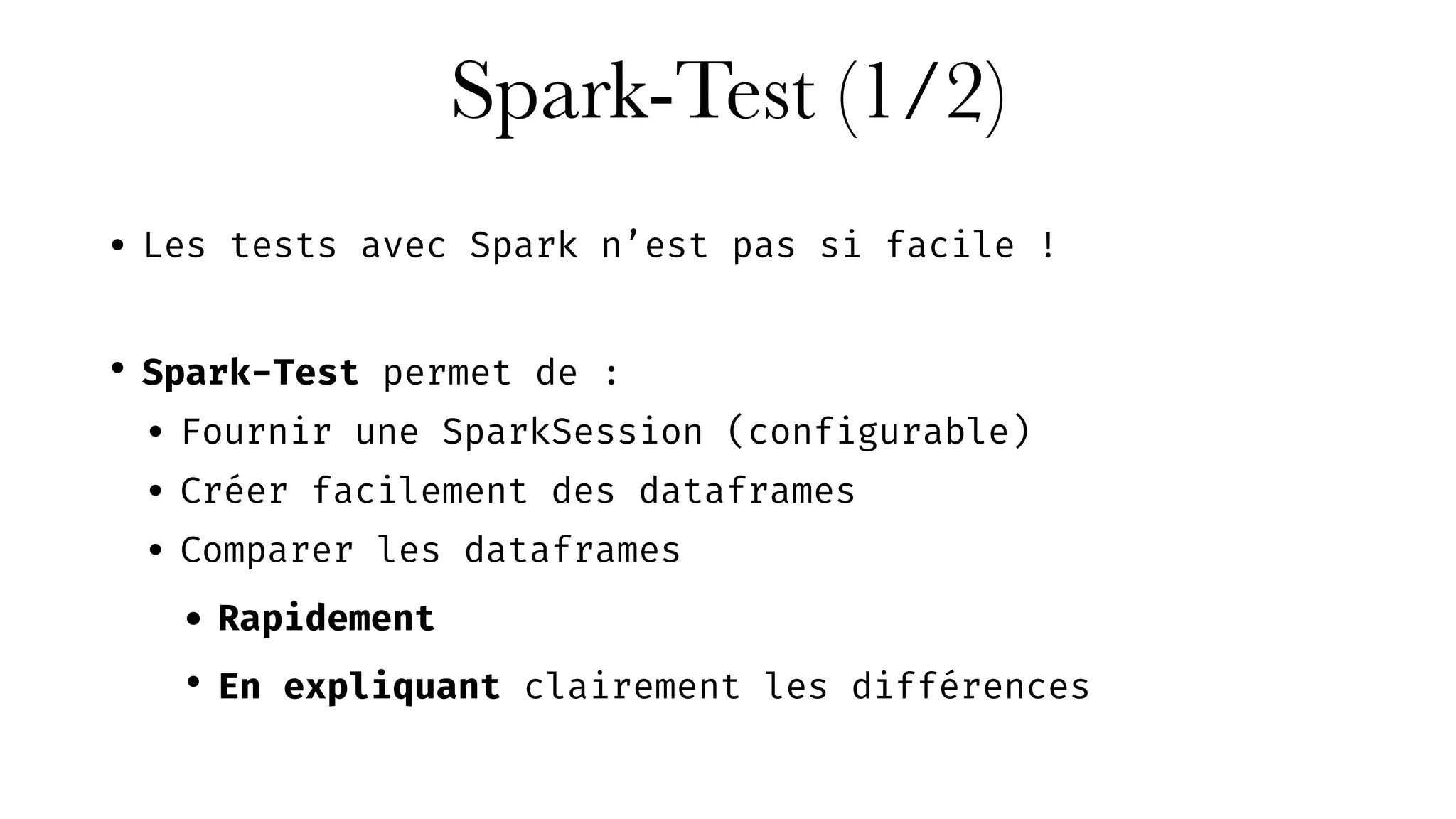

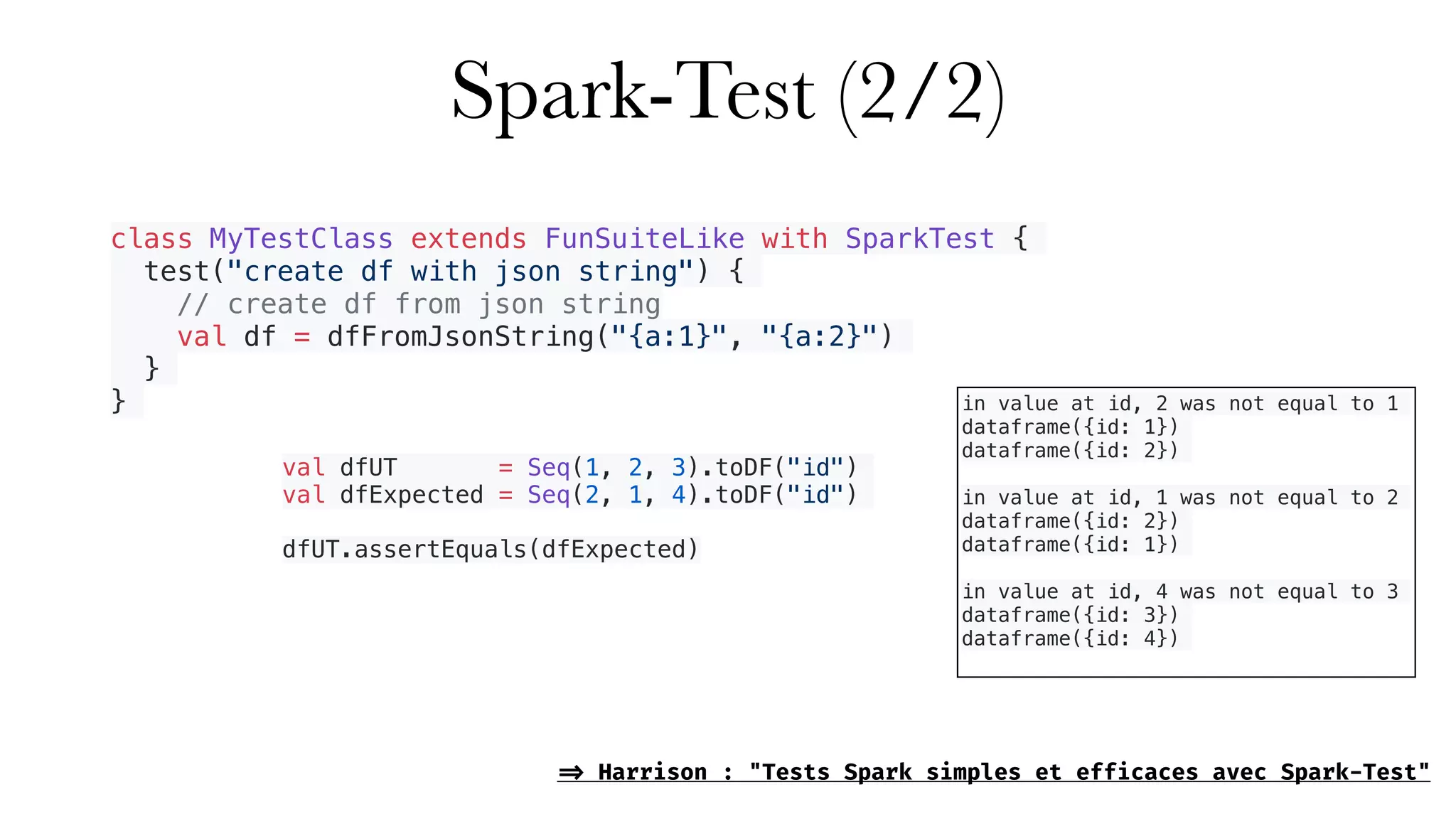

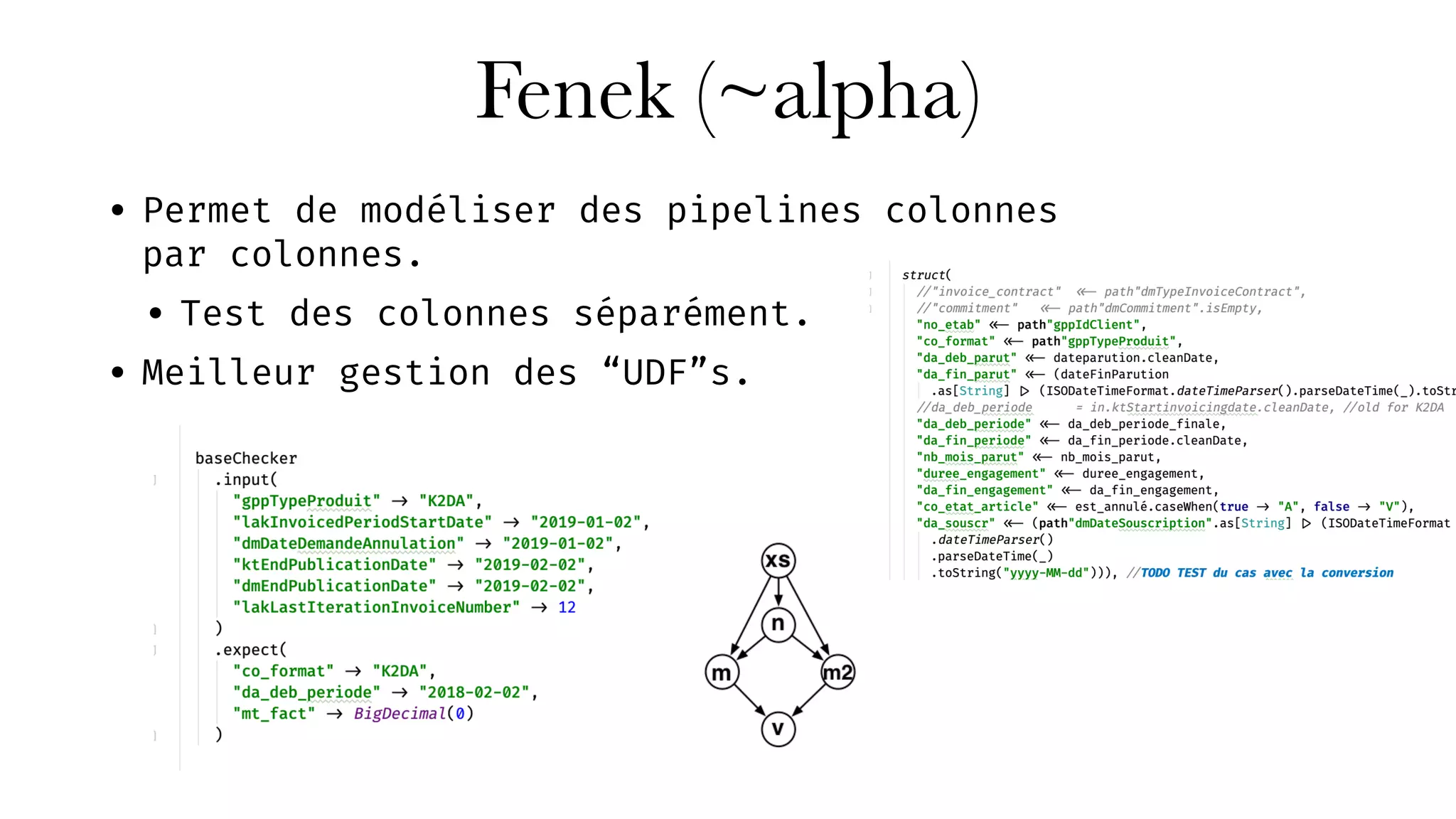

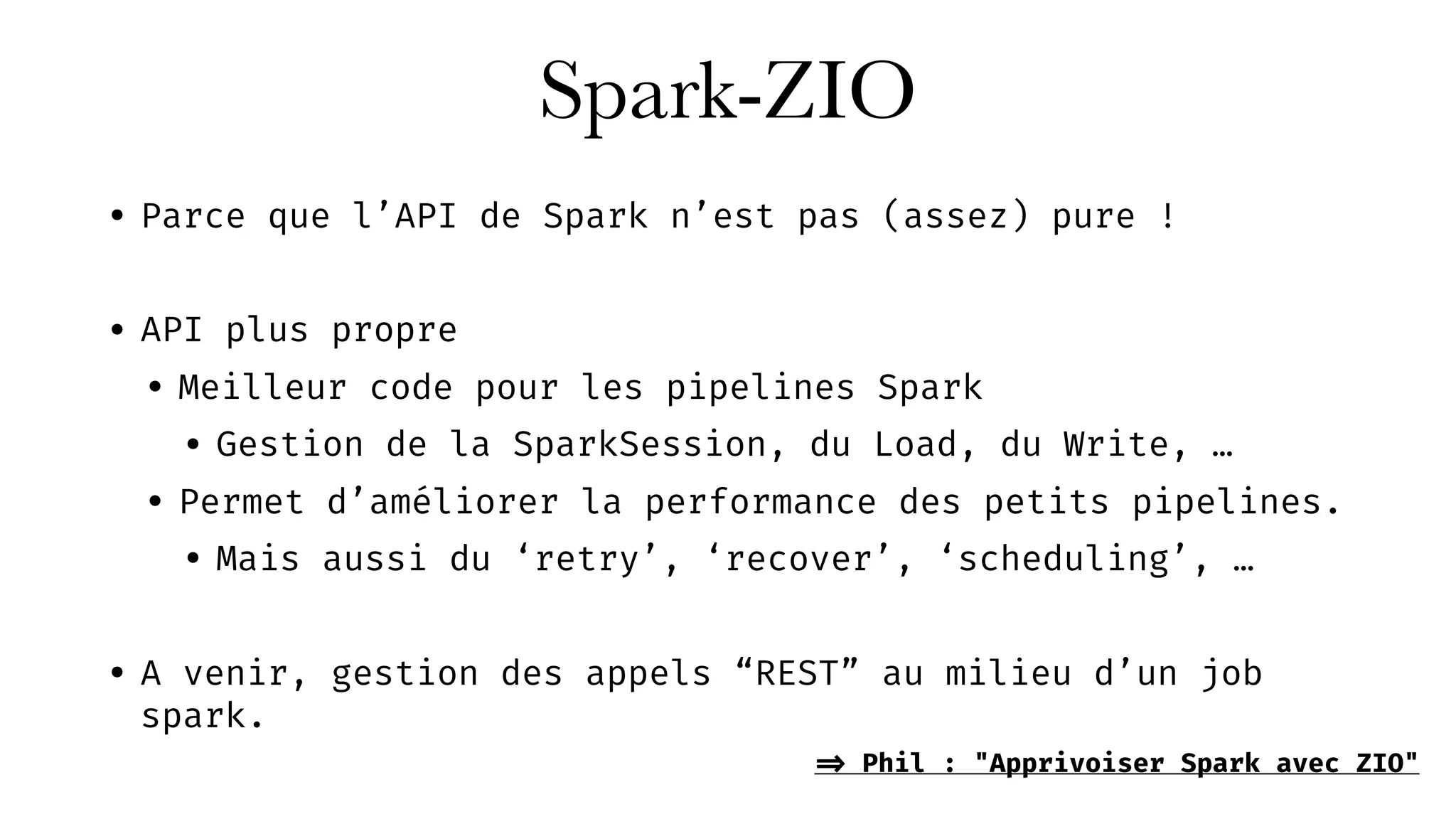

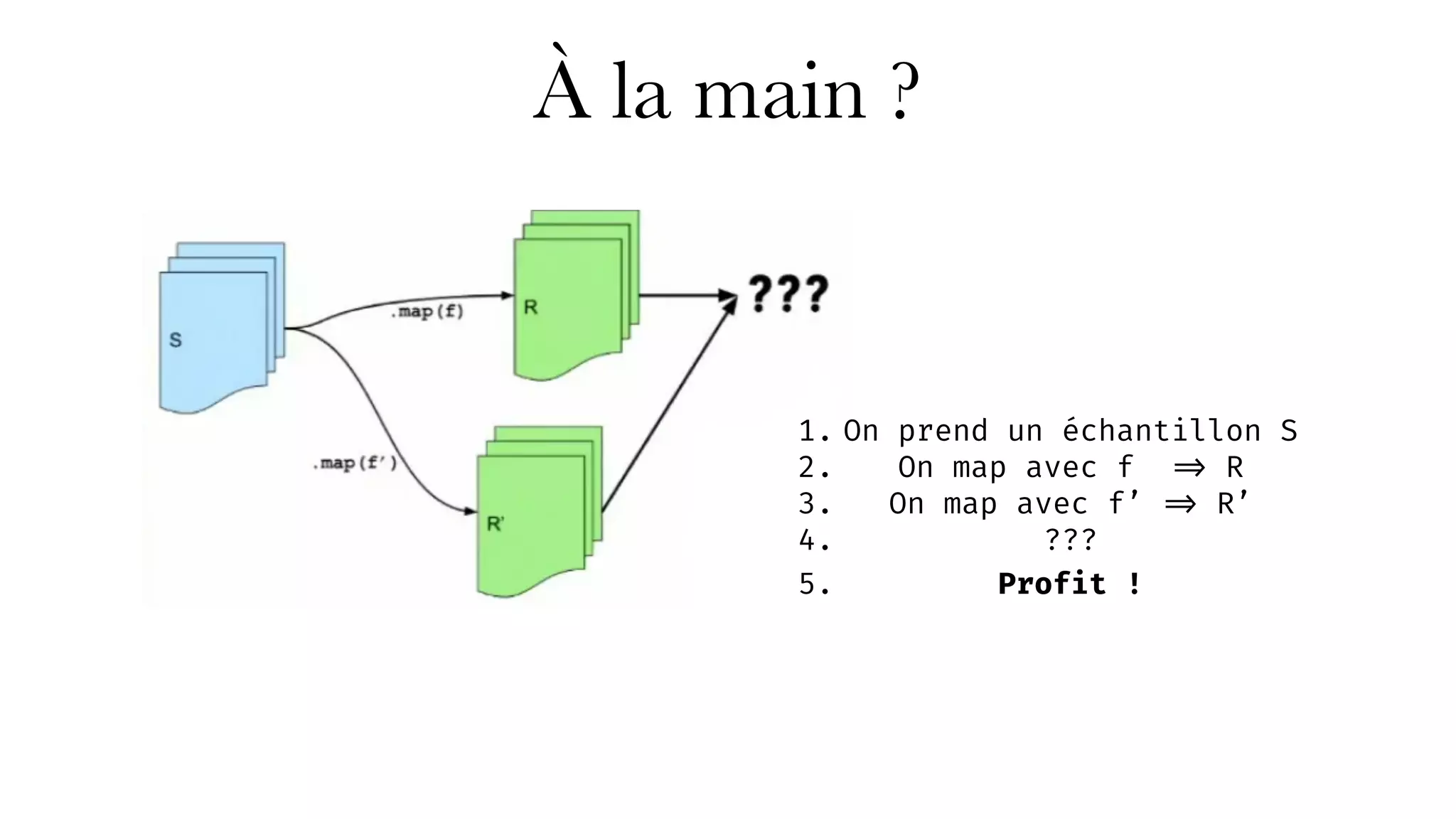

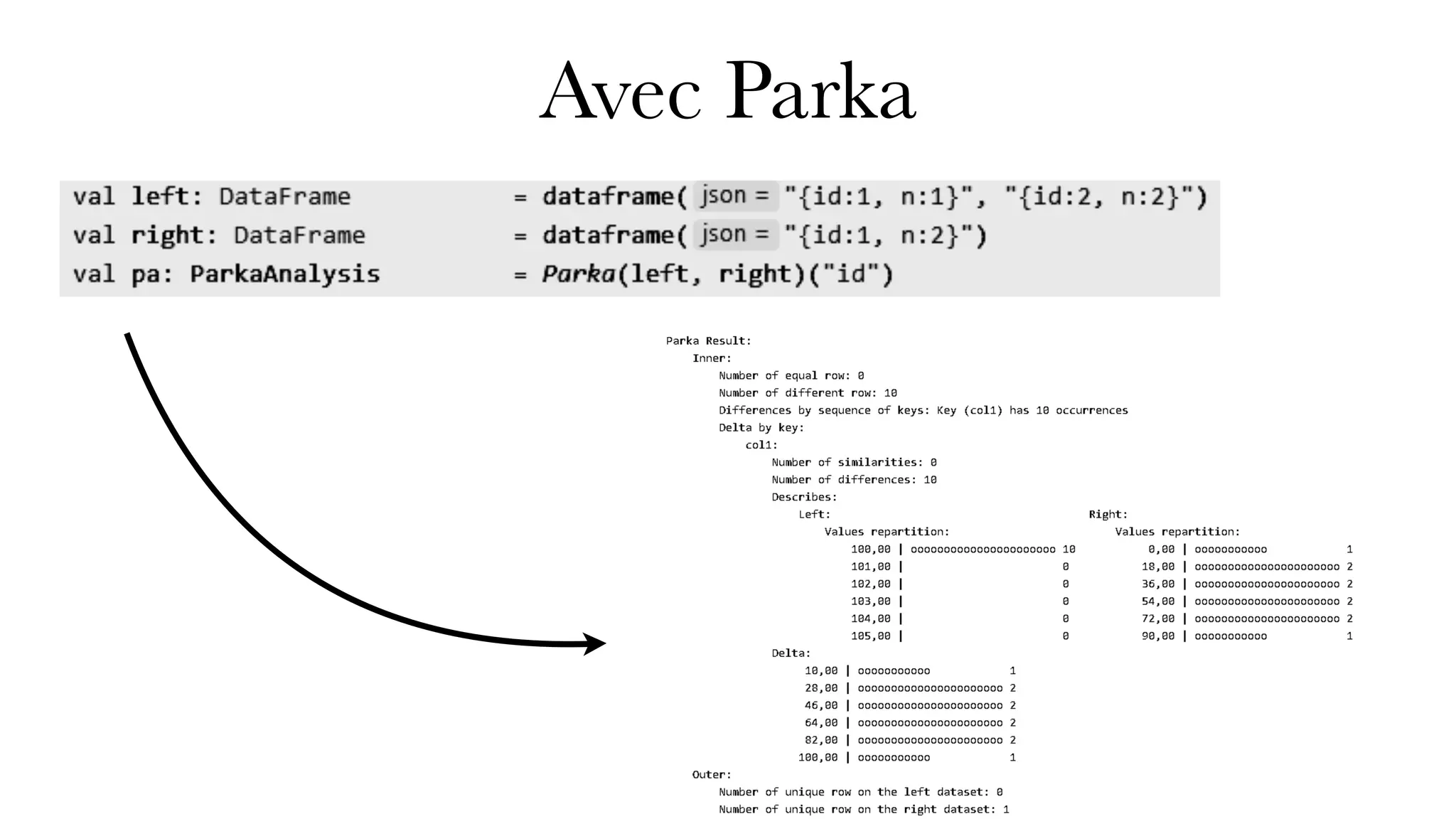

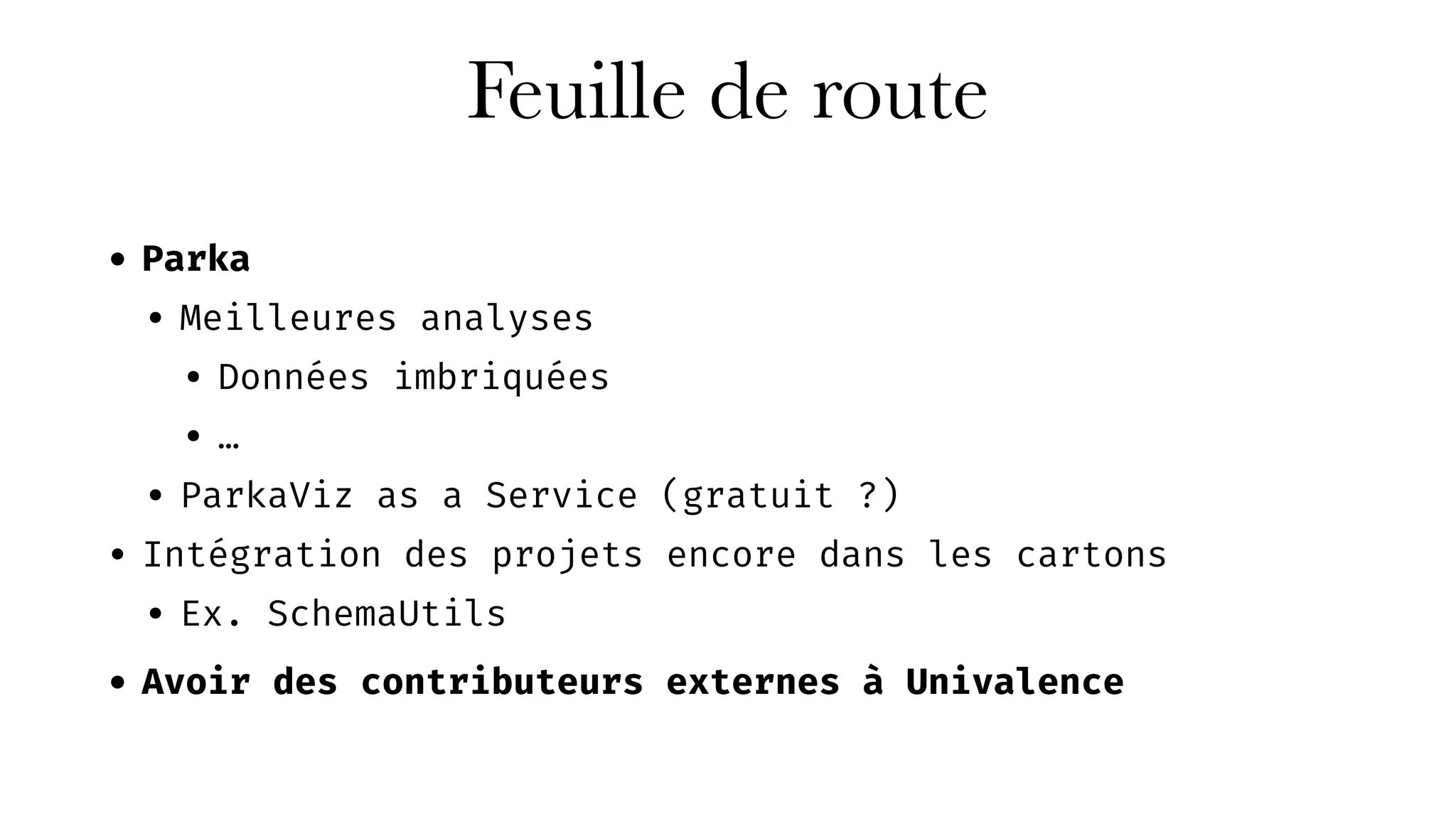

Le document présente Univalence, un cabinet d'expertise en data engineering co-organisé par Jonathan Winandy, qui se concentre sur l'amélioration des pratiques d'ingénierie des données à travers le conseil, l'audit, et des formations sur des outils comme Scala et Spark. Il détaille plusieurs projets, dont 'spark-test' pour faciliter les tests avec Spark, et 'cent centrifuge', destiné à la gestion de la qualité des données. La feuille de route inclut le développement de nouveaux outils et l'intégration de projets supplémentaires.