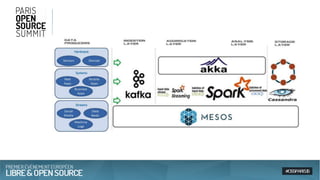

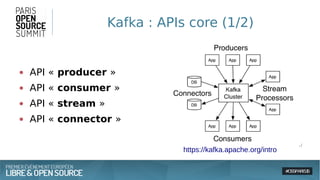

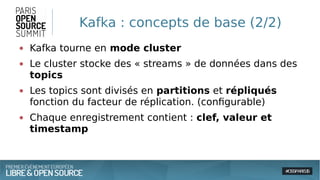

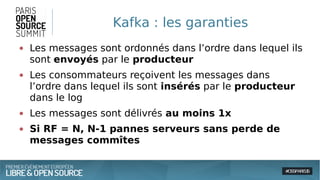

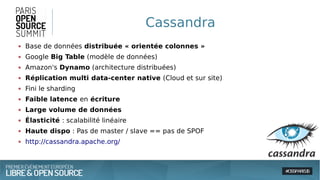

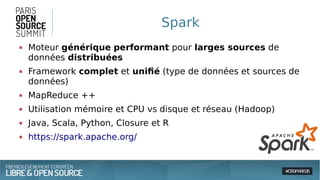

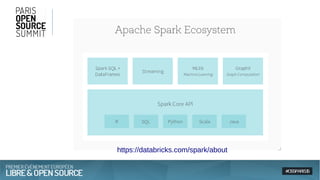

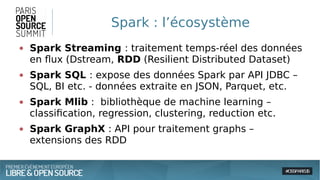

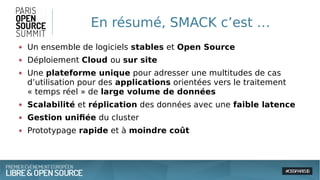

Le document présente une approche architecturale pour le traitement des données massives en utilisant des technologies open source comme Spark, Akka, Cassandra et Kafka. Il explore les défis du big data, les avantages de chaque outil et leur intégration pour un traitement en temps réel et une gestion efficace des systèmes distribués. Enfin, il souligne la scalabilité et la faible latence nécessaires pour des applications orientées données.