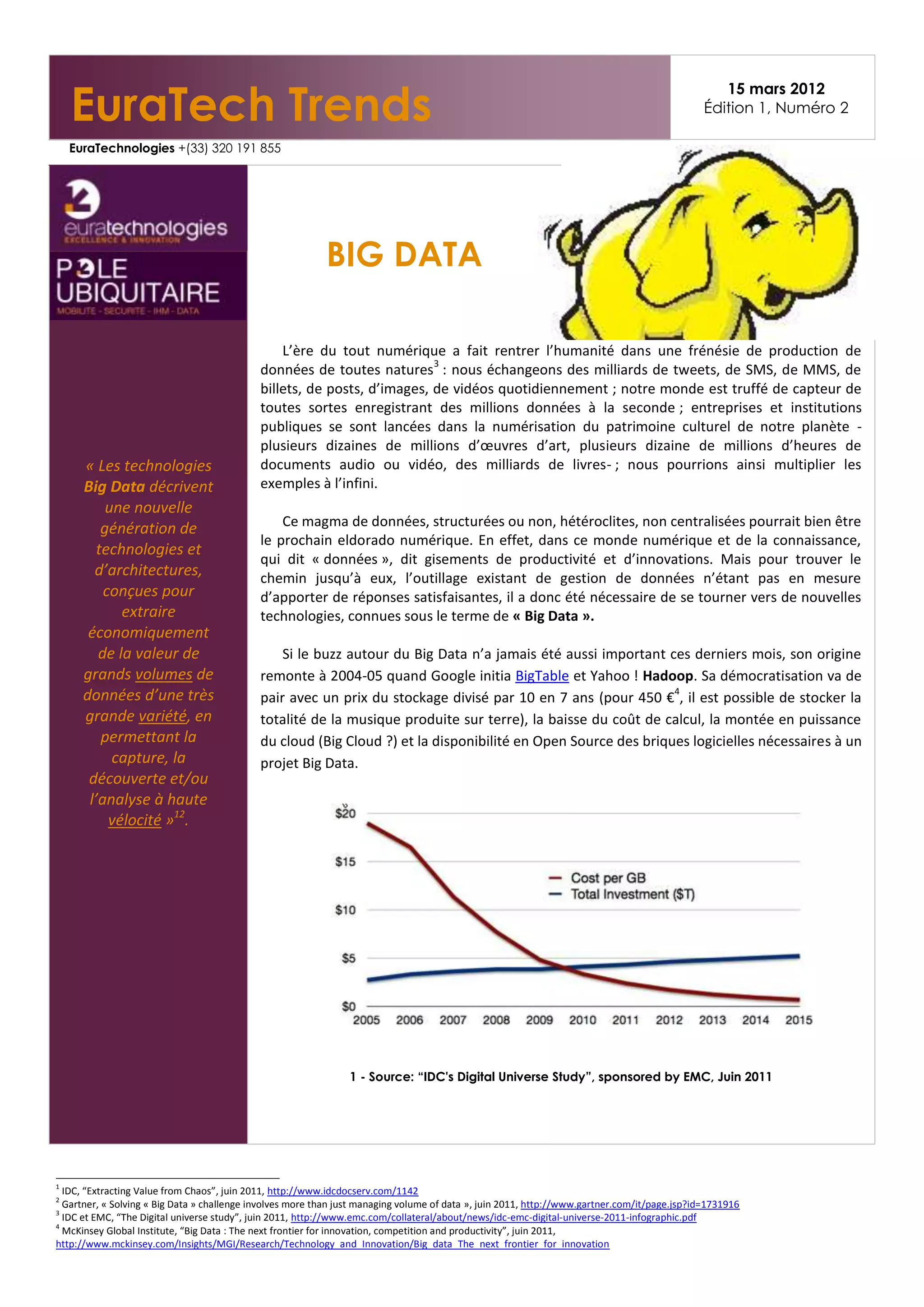

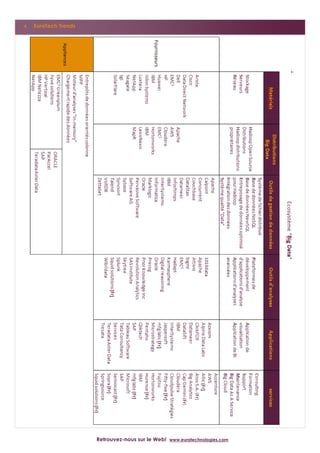

L'article explore l'émergence des big data dans un contexte de frénésie numérique, soulignant la nécessité d'outils dédiés tels que Hadoop et NoSQL pour gérer et analyser des volumes massifs de données. Il décrit également la croissance rapide du marché, avec des prévisions de revenus allant de 1,5 à 5 milliards de dollars pour 2012, et des cas d'utilisation dans divers secteurs. Enfin, il met en lumière l'importance des compétences diverses requises pour la mise en œuvre de projets big data, tout en mentionnant les acteurs clés et les start-ups dans ce domaine.