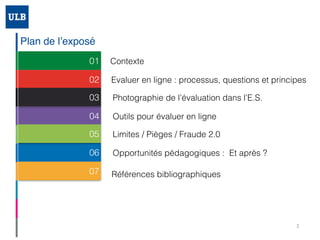

Le document de Sylviane Bachy aborde l'évaluation en ligne, mettant en lumière les processus, les questions, et les principes associés, ainsi que les obstacles liés à la fraude et aux pratiques évaluatives. Il examine les opportunités pédagogiques offertes par cette nouvelle modalité, tout en soulignant les défis tels que le stress des étudiants et la gestion du temps. Enfin, il propose des stratégies pour améliorer les pratiques d'évaluation et renforcer la confiance dans les résultats.