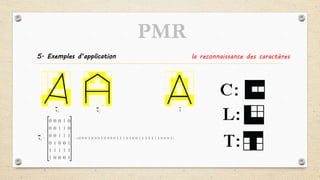

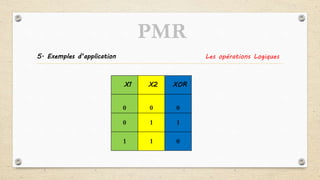

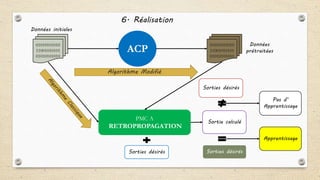

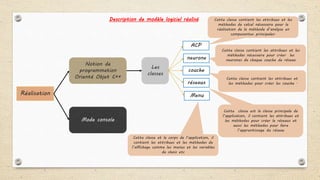

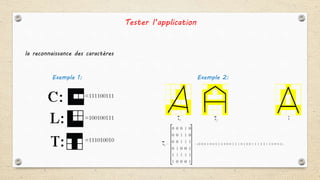

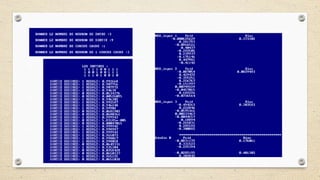

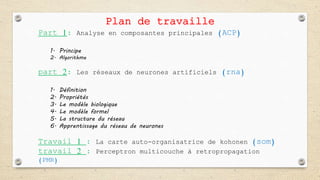

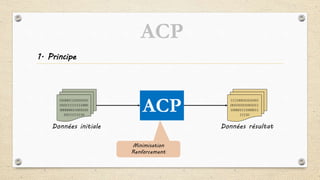

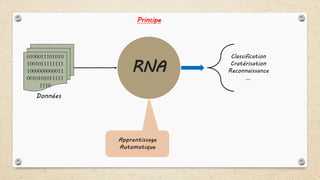

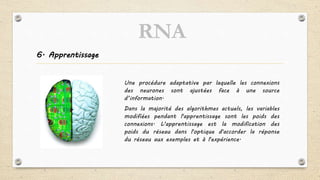

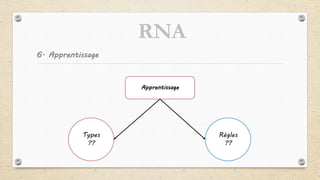

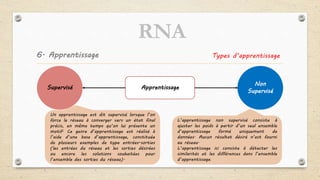

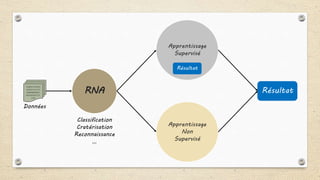

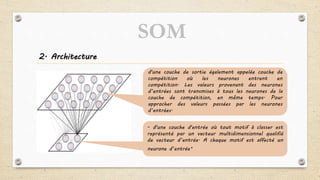

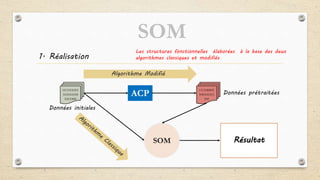

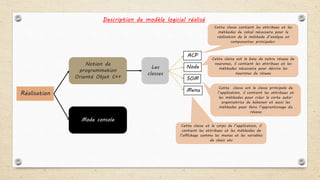

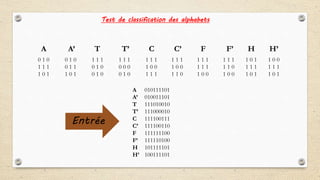

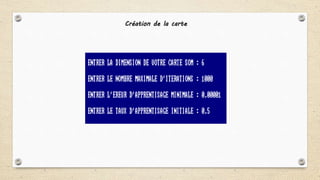

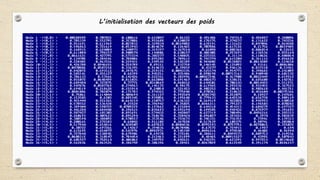

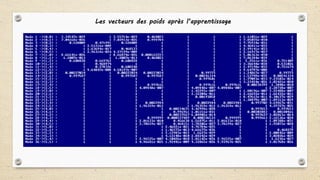

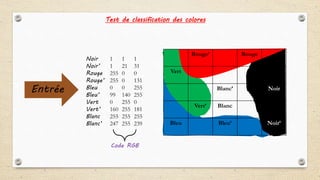

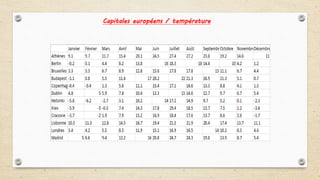

Ce document présente un projet de fin d'études portant sur l'étude et la réalisation d'un modèle de réseaux de neurones artificiels, incluant divers types d'apprentissage tels que supervisé et non supervisé. Il détaille les principes fondamentaux comme l'Analyse en Composantes Principales (ACP) et les différentes structures des réseaux de neurones, tout en illustrant l'application de ces concepts à travers des algorithmes tels que la Carte Auto-Organisatrice de Kohonen et le Perceptron Multicouche. Enfin, il aborde les réalisations pratiques et les tests effectués, notamment dans le domaine de la classification et de la reconnaissance.

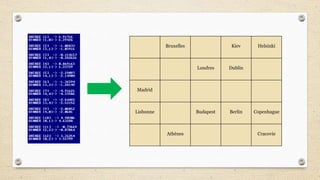

![x1

x3

x2

O2

O1

W11

Couche d’entre

Couche de cache

𝛿𝑜1

𝛿ℎ1

W41

W42

W43

y1

W13

W12

Couche de sortieb1

b4

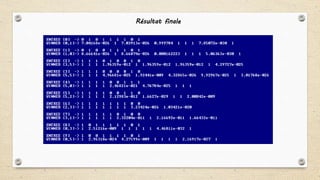

4 . Correction des poids des liens

entre les neurones de la couche de

sortie et de la première couche

cachée selon l’erreur présente en

sortie

𝛿𝑜i = 𝒻 ′( 𝒴𝒿𝒲𝒿𝓀 + 𝑏𝑖) ∗ (𝑑i − Oi)

𝛿ℎj = 𝒻 ′( 𝑥𝑖𝒲𝑖𝑗 + 𝑏𝑗 )( 𝛿𝑜𝑖𝑤𝑖𝑗)

𝒘𝒏=wn+𝜼∗𝛿𝑜1∗O1+ 𝜶∗wn

𝒻′ 𝓍

= 𝒻 𝓍 [1 − 𝒻 𝓍 ]](https://image.slidesharecdn.com/prsentationpfe-160923220159/85/Presentation-pfe-50-320.jpg)