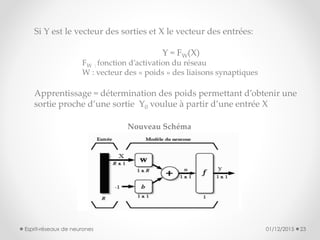

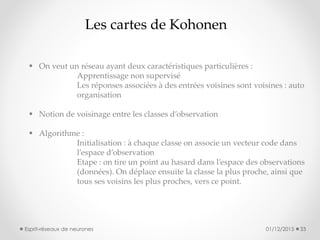

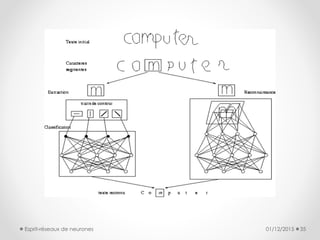

Le document présente une introduction aux réseaux de neurones, discutant de leur histoire, de leur architecture, et des paradigmes d'apprentissage. Il explique les analogies entre neurones biologiques et formels, décrit plusieurs modèles tels que le perceptron multicouche et les cartes de Kohonen, et souligne leurs applications variées. Enfin, il conclut sur le potentiel futur des réseaux de neurones dans divers domaines, en s'appuyant sur des bases mathématiques solides.