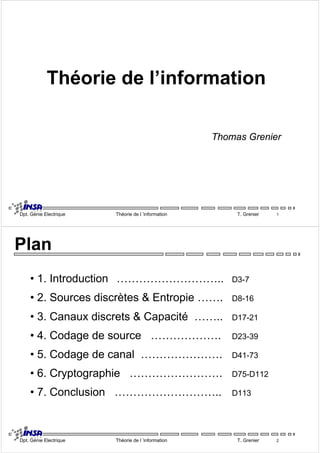

Le document traite de la théorie de l'information selon Shannon, abordant des concepts clés tels que les sources discrètes, l'entropie, les canaux de communication et les techniques de codage. Il explore le modèle de communication, les types de sources et de canaux, ainsi que les applications pratiques telles que la cryptographie. Enfin, des théorèmes fondamentaux sont présentés, mettant l'accent sur le codage de source et le codage de canal.

![9Source : siège d'évènements aléatoires qui constituent

le message émis Ö Entropie

9Canal : transmet et dégrade le message Ö Capacité

Des messages différents portent la même information, le codage

cherche le message avec les meilleures propriétés.

9Codage de source Ö supprime la redondance, réduit le coût

9Codage de canal Ö protège contre les perturbations

9Cryptage Ö protège contre les curieux

Deux théorèmes fondamentaux :

z Codage de source z Codage de canal

Dpt. Génie Electrique Théorie de l ’information T. Grenier 7

2. Sources discrètes & Entropie

Sources débitant des messages sous forme discrète !

9Source discrète d'information : suite de variables aléatoires

discrètes X1, X2, … Xn

9Symbole ou lettre : élément fondamental irréductible

contenant une information, cad réalisation particulière de la

source d'information.

9Mot : succession finie de symboles

9Alphabet : totalité des D lettres

[X] = [x1,x2, …., xD]

Dpt. Génie Electrique Théorie de l ’information T. Grenier 8](https://image.slidesharecdn.com/1-entropie-capacite-141019122821-conversion-gate02/85/1-entropie-capacite-theorie-de-l-information-4-320.jpg)

![3. Canaux discrets & Capacité

9Canal : milieu de transmission de l'information situé entre la source

et la destination. Le canal opère une transformation entre l'espace

des symboles à l'entrée et celui de la sortie.

9Canal discret : les espaces d'entrée et de sortie sont discrets

9Canal continu : les espaces d'entrée et de sortie sont

continus

9Canal sans mémoire : si la transformation d'un symbole x à

l'entrée en un symbole y en sortie ne dépend pas des

transformations antérieures

9Canal stationnaire : si les transformations ne dépendent pas de

l'origine des temps

Dpt. Génie Electrique Théorie de l ’information T. Grenier 17

[ ]

⎤

⎥ ⎥ ⎥ ⎥ ⎦

⎡

=

⎢ ⎢ ⎢ ⎢

⎣

m

m

x y x y ...

x y

1 1 1 2 1

x y x y x y

2 1 2 2 2

... ...

x y x y ...

x y

n n n m

X .

Y

1 2

[ ]

⎡

=

p x y p x y p x y

( , ) ( , ) ... ( , )

1 1 1 2 1

m

p x y p x y p x y

( , ) ( , ) ( , )

2 1 2 2 2

... ...

n n n m

• Probabilités marginales

i i j p x p x y

( ) ( , )

j i j p y p x y

( ) ( , )

i x p x p X H Σ=

j y p y p Y H Σ=

Dpt. Génie Electrique Théorie de l ’information T. Grenier 18

⎤

⎥ ⎥ ⎥ ⎥

⎦

⎢ ⎢ ⎢ ⎢

⎣

( , ) ( , ) ... ( , )

( , )

1 2

m

p x y p x y p x y

P X Y

Σ=

=

m

j

1

Σ=

=

n

i

1

( ) ( ).log( ( ))

1

i

n

i

= −

( ) ( ).log( ( ))

1

j

m

j

= −](https://image.slidesharecdn.com/1-entropie-capacite-141019122821-conversion-gate02/85/1-entropie-capacite-theorie-de-l-information-9-320.jpg)