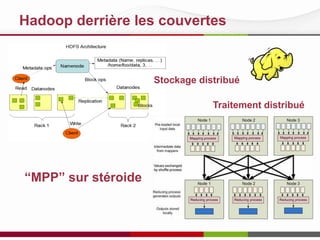

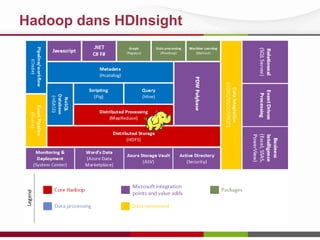

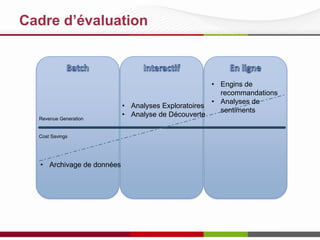

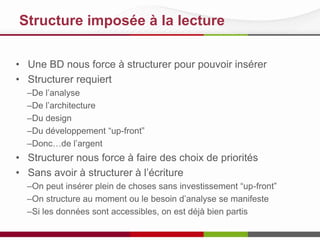

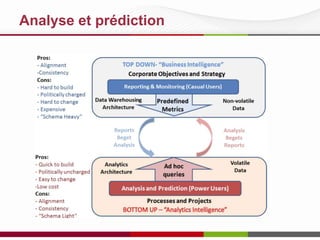

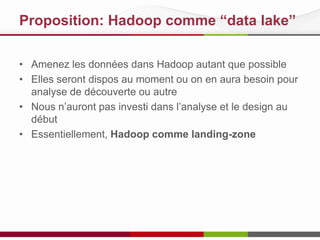

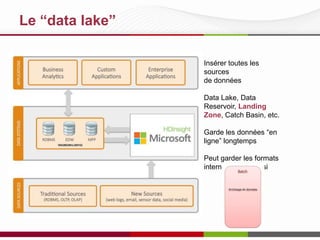

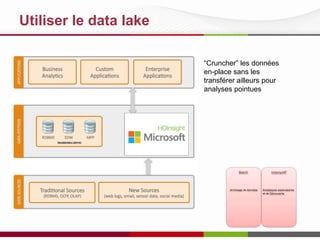

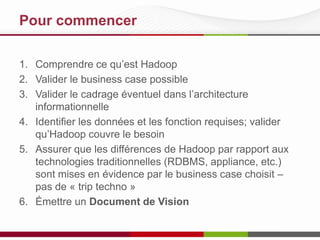

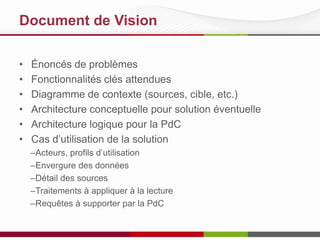

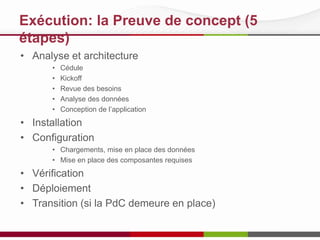

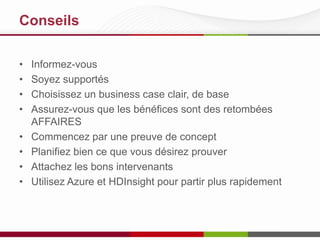

Le document présente les opportunités d'utilisation de Hadoop en entreprise, mettant en avant sa capacité à gérer de vastes volumes de données de manière économique sans nécessiter de structuration préalable. Il propose l'idée de Hadoop en tant que 'data lake', facilitant l'archivage et l'analyse exploratoire des données. Des conseils pratiques sur la mise en œuvre de Hadoop sont également fournis, soulignant l'importance d'une preuve de concept et d'une planification rigoureuse.