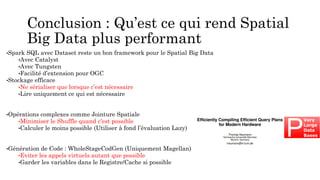

Le document explore les défis et les approches pour le traitement des données spatiales massives en utilisant Spark, notamment en se concentrant sur les concepts de partitionnement, d'optimisation et d'extensions adaptées. Il décrit comment les RDD et les DataFrames peuvent être utilisés pour gérer des données géospatiales, en soulignant les avantages de SparkSQL et de l'optimiseur Catalyst pour améliorer les performances. En conclusion, l'intégration de Spark avec des fonctionnalités spécifiques aux données spatiales permet d'optimiser les performances et de faciliter le traitement des données complexes.