Ce document explique comment utiliser Hadoop en Perl via Hadoop Streaming pour traiter des données, en détaillant l'importation avec Sqoop, l'écriture de scripts MapReduce en Perl, et l'exécution des tâches sur Hadoop. Il présente des exemples pratiques pour générer des combinaisons fréquentes d'achats pour les clients d'un site e-commerce, mettant en évidence l'efficacité de Hadoop pour des automatisations complexes. Les étapes comprennent l'importation, l'écriture de scripts, le test et le lancement de Hadoop pour obtenir les résultats.

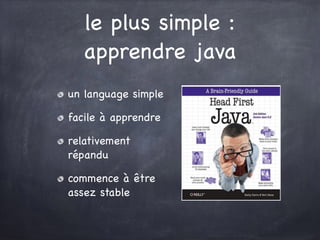

![etape 1 : importation des

données avec sqoop

Les données vont être écrite sous forme

tabulaire dans HDFS,

dans /user/hive/warehouse/

db_table_whatever/part-000[0-9]{2}

Utilisable avec HiveQL directment

mais sinon :

hadoop fs -put ./fichier.tsv /user/dmorel/](https://image.slidesharecdn.com/bigdata-fpw2012-part2-151115221102-lva1-app6892/85/Utiliser-Hadoop-en-perl-avec-HadoopStreaming-5-320.jpg)

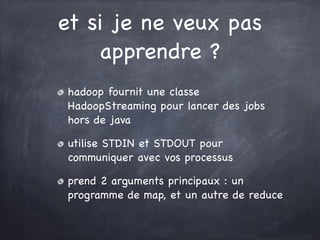

![etape 2 : écriture des

scripts map + reduce

while ( <STDIN> ) {

chomp;

my @fields = split /t/;

# make the key

print join( '+', @fields[ ( 16, 25 ) ] );

# separate key and value

print "+t";

# make the value

print join(",",

@fields[ ( 28, 30, ... ) ] ) . "n";

}](https://image.slidesharecdn.com/bigdata-fpw2012-part2-151115221102-lva1-app6892/85/Utiliser-Hadoop-en-perl-avec-HadoopStreaming-6-320.jpg)

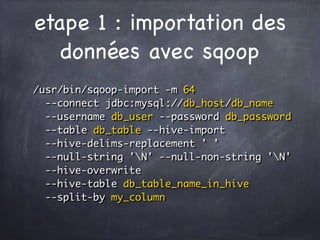

![le mapper peut être plus

«complexe» !

while ( <STDIN> ) {

chomp;

my @fields = split /t/;

# make the key

my $key = join( '+',

@fields[ ( 16, 25 ) ] , q{} );

# make the valueS

my @base_values = @fields[ ( 28 .. 150 ) ] );

my @final_vals = mybigcombinesub(@base_values);

for ( @final_values ) {

print $key, join(«t», @$_), «n»;

}

}](https://image.slidesharecdn.com/bigdata-fpw2012-part2-151115221102-lva1-app6892/85/Utiliser-Hadoop-en-perl-avec-HadoopStreaming-7-320.jpg)

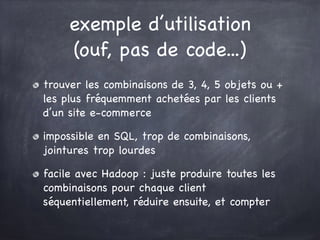

![reducer : analyser ligne à

ligne, vérifier le key switch

my ($k_prev, $processed_lines_in_key,

@output_lines, $value_to_print);

while (<STDIN>) {

chomp;

my ($key, $value) = split /t/;

if ( $k_main ne $k_prev ) {

$processed_lines_in_key = 0;

_flush_to_stdout(@output_lines);

$value_to_print = ''; $k_prev = $k_main;

}

$value_to_print .= $value;

push @output_lines, [ $k_main, $value_to_print ]

if (int (rand()*3) == 2);

}](https://image.slidesharecdn.com/bigdata-fpw2012-part2-151115221102-lva1-app6892/85/Utiliser-Hadoop-en-perl-avec-HadoopStreaming-9-320.jpg)