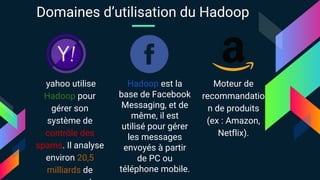

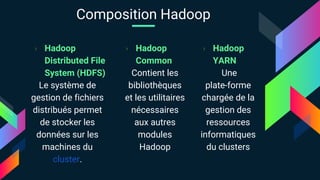

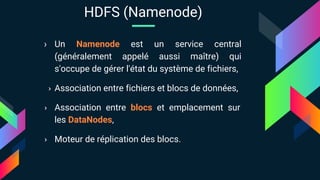

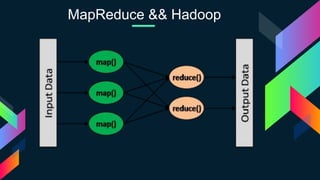

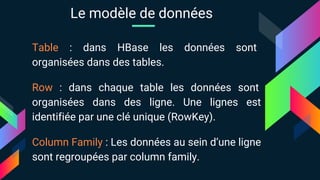

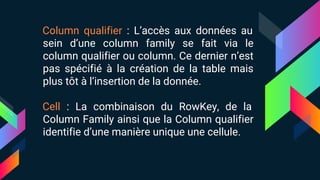

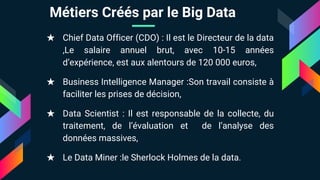

Le document présente une analyse détaillée des défis et solutions liés au Big Data, en mettant particulièrement l'accent sur Hadoop, une plateforme distribuée conçue pour stocker et traiter d'importantes quantités de données. Il décrit les concepts clés du Big Data, les technologies comme le cloud computing et MapReduce, ainsi que les divers cas d'utilisation de Hadoop dans des entreprises telles que Yahoo et Facebook. Enfin, il évoque l'importance croissante des métiers liés aux données dans le contexte de l'explosion des données numériques.