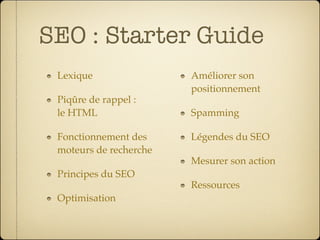

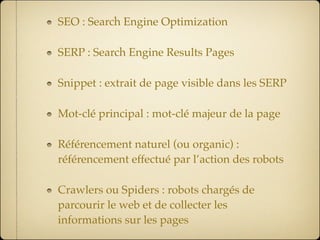

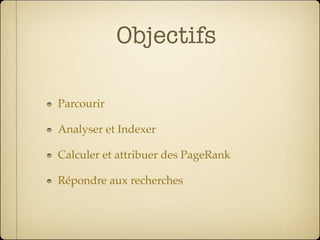

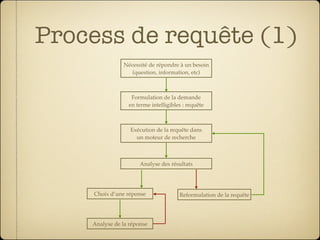

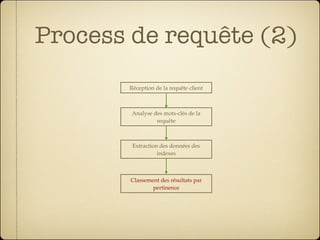

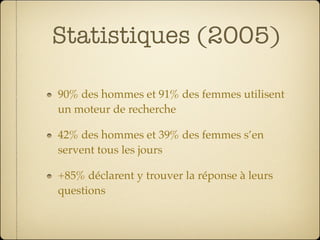

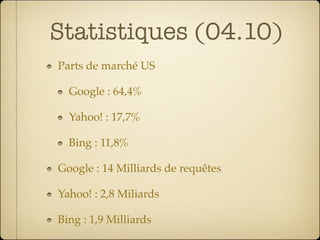

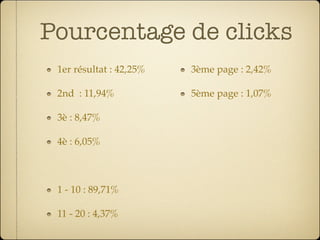

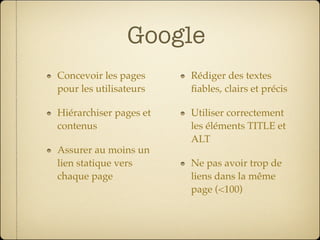

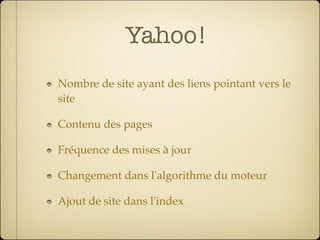

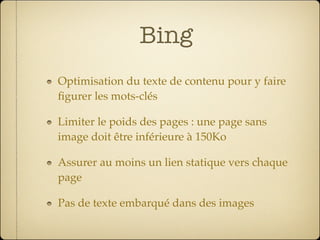

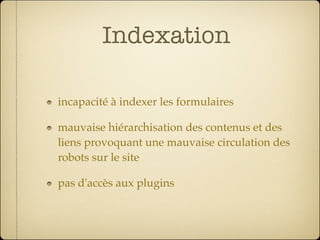

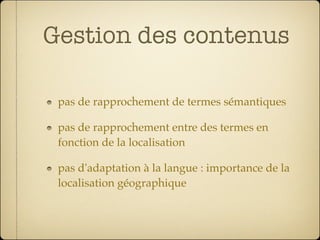

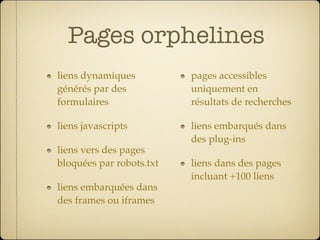

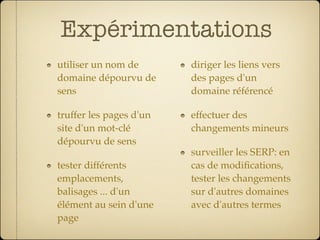

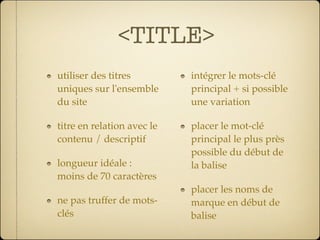

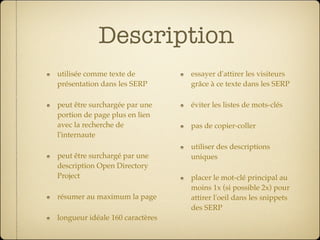

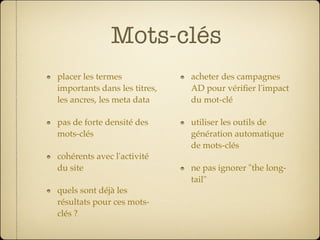

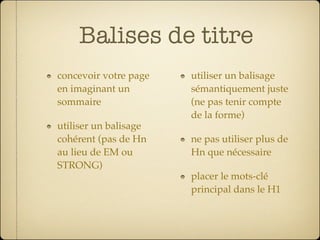

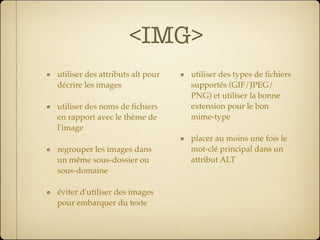

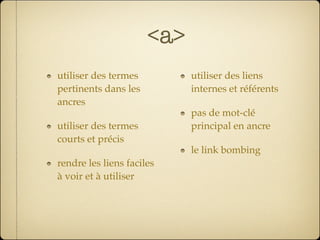

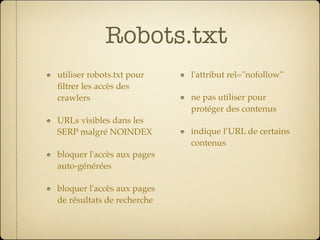

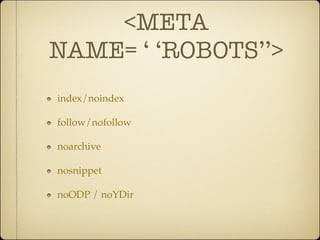

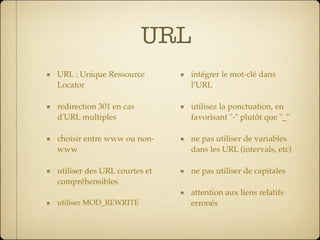

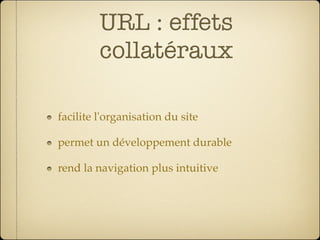

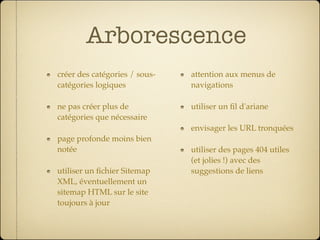

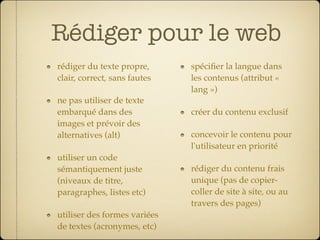

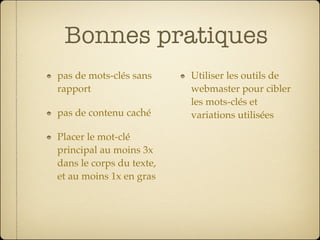

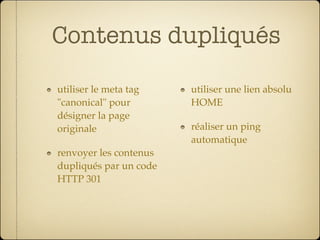

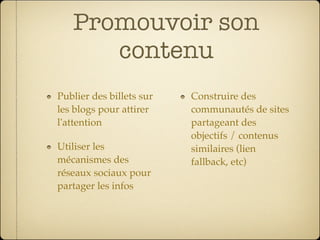

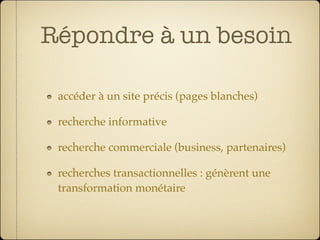

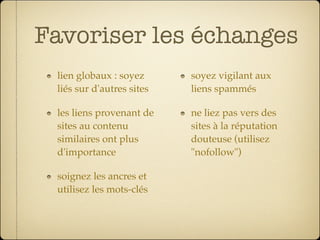

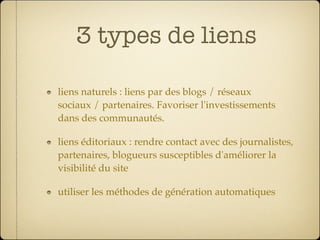

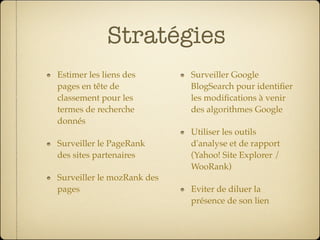

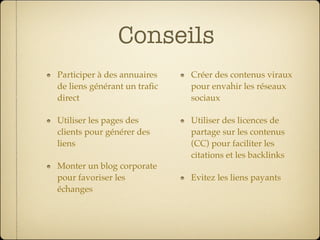

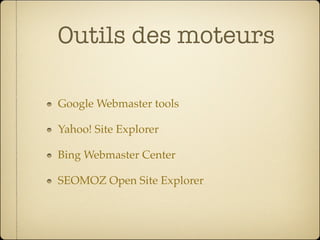

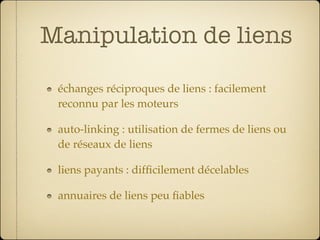

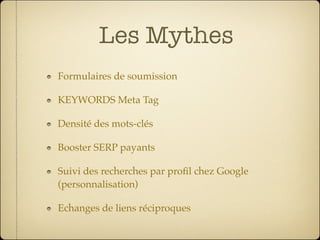

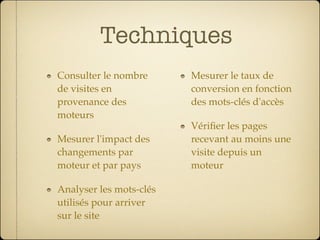

Le document présente un guide complet sur le référencement SEO, détaillant les principes, techniques et bonnes pratiques pour améliorer la visibilité d'un site sur les moteurs de recherche. Il aborde des concepts tels que l'indexation, l'optimisation du contenu, l'utilisation des mots-clés, ainsi que les recommandations spécifiques pour les principaux moteurs de recherche. Les statistiques sur l'utilisation des moteurs de recherche et les conseils pour éviter des techniques de spam sont également inclus.