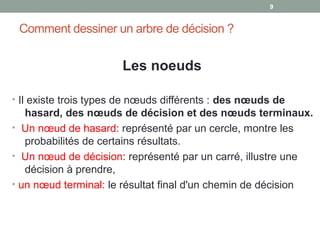

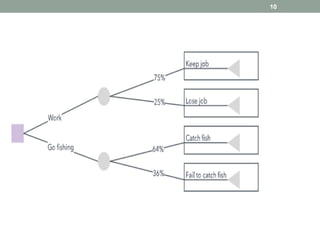

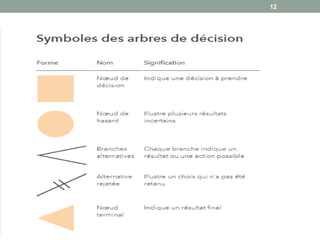

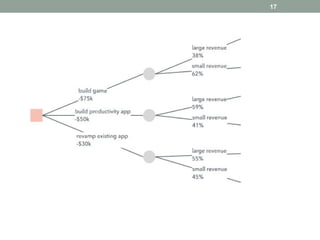

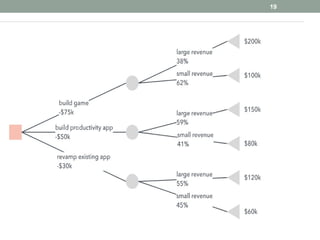

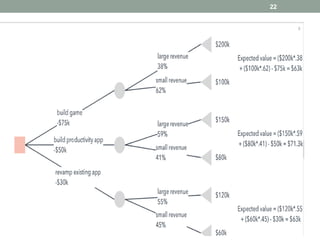

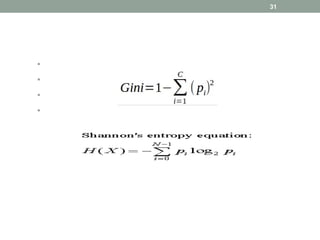

Les arbres de décision sont des outils d'analyse utilisés en business intelligence pour évaluer les choix possibles en fonction de leurs coûts et bénéfices. Ils se composent de différents types de nœuds (décision, hasard, terminal) et sont utilisés pour la classification et la régression. Les arbres de décision sont appréciés pour leur simplicité et leur capacité à visualiser des options, bien qu'ils présentent des inconvénients liés à la complexité et au surapprentissage.